RTX 4000シリーズ最上位モデルの「RTX 4090」を自腹で買いました。

1世代前のRTX 3090や下位モデル(RTX 4080など)の性能差はもちろん、配信に便利なAV1エンコードや、4K動画編集やAIイラスト性能などなど。総合的に詳しくベンチマークします。

(公開:2022/10/26 | 更新:2023/5/4)

「RTX 4090」の仕様とスペック

| GPU | RTX 4090 | RTX 3090 | Titan RTX |

|---|---|---|---|

| プロセス | 5 nm製造 : TSMC | 8 nm製造 : Samsung | 12 nm製造 : TSMC |

| シェーダー数CPUのコア数に相当 | 16384 | 10496 | 4608 |

| RTコア数レイトレ用の特化コア | 128 | 82 | 72 |

| ブーストクロック | 2520 MHz | 1695 MHz | 1770 MHz |

| VRAM | GDDR6X 24 GB | GDDR6X 24 GB | GDDR6 24 GB |

| 理論性能(FP32) | 82.58 TFLOPS | 35.58 TFLOPS | 16.31 TFLOPS |

| ECCメモリ | 対応 | – | – |

| PCIe | PCIe 4.0 x16 | PCIe 4.0 x16 | PCIe 3.0 x16 |

| TDP | 450 W | 350 W | 280 W |

| 補助電源 | 16-pin | 12-pin | 8 + 8 pin |

| MSRP | $ 1599 | $ 1499 | $ 2499 |

| 参考価格 | 264800 円 | 199000 円 | 321840 円 |

| 発売価格 | 289300 円 | 212278 円 | 321840 円 |

| 発売 | 2022/10/12 | 2020/9/24 | 2018/12/19 |

| GPU | RTX 4090 | RTX 3090 | Titan RTX |

|---|---|---|---|

| 世代 | Ada Lovelace | Ampere | Turing |

| プロセス | 5 nm製造 : TSMC | 8 nm製造 : Samsung | 12 nm製造 : TSMC |

| トランジスタ数 | 763.0 億 | 283.0 億 | 186.0 億 |

| ダイサイズ | 608 mm2 | 628 mm2 | 754 mm2 |

| シェーダー数CPUのコア数に相当 | 16384 | 10496 | 4608 |

| TMU数Texture Mapping Unitのこと | 512 | 328 | 288 |

| ROP数Render Output Unitのこと | 176 | 112 | 96 |

| 演算ユニット数 | 128 | 82 | 72 |

| Tensorコア数機械学習向けの特化コア | 512 | 328 | 576 |

| RTコア数レイトレ用の特化コア | 128 | 82 | 72 |

| L1キャッシュ演算ユニットあたり | 128 KB | 128 KB | 64 KB |

| L2キャッシュコア全体で共有 | 72.0 MB | 6.0 MB | 6.0 MB |

| L3キャッシュコア全体で共有 | – | – | – |

| クロック周波数 | 2235 MHz | 1395 MHz | 1350 MHz |

| ブーストクロック | 2520 MHz | 1695 MHz | 1770 MHz |

| VRAM | GDDR6X 24 GB | GDDR6X 24 GB | GDDR6 24 GB |

| VRAMバス | 384 bit | 384 bit | 384 bit |

| VRAM帯域幅 | 1008 GB/s | 936.2 GB/s | 672.0 GB/s |

| 理論性能(FP32) | 82.58 TFLOPS | 35.58 TFLOPS | 16.31 TFLOPS |

| ECCメモリ | 対応 | – | – |

| PCIe | PCIe 4.0 x16 | PCIe 4.0 x16 | PCIe 3.0 x16 |

| TDP | 450 W | 350 W | 280 W |

| 補助電源 | 16-pin | 12-pin | 8 + 8 pin |

| MSRP | $ 1599 | $ 1499 | $ 2499 |

| 参考価格 | 264800 円 | 199000 円 | 321840 円 |

| 発売価格 | 289300 円 | 212278 円 | 321840 円 |

| 発売 | 2022/10/12 | 2020/9/24 | 2018/12/19 |

RTX 4090とRTX 3090のスペックをざっくり比較すると、こんな感じ↓

- シェーダー数:RTX 4090 > RTX 3090

16384シェーダー:10496シェーダー - 最大クロック:RTX 4090 > RTX 3090

2520 MHz:1695 MHz - VRAM容量:RTX 4090 = RTX 3090

24 GB(1008 GB/s):24 GB(936 GB/s) - 消費電力:RTX 4090 > RTX 3090

TDP 450 W:TDP 350 W - 新品価格:RTX 4090 > RTX 3090

約26万円~:約20万円~

RTX 3090の後継モデルにふさわしい正統進化を遂げた、ほぼ文句のつけようがないスペックに仕上がっています。

価格設定が100ドル高い1599ドルに設定されたものの、スペックの上昇幅(+133%)は価格の値上げ分(+7%)をはるかに上回っており、コストパフォーマンスの改善は決定的です。

VRAM容量も先代に引き続き24 GBを維持。バス幅も384 bitを維持したままメモリの動作クロックを向上させ、帯域幅を約936 GB/sから約1008 GB/s(秒速1テラバイト近い)に引き上げます。

製造を担当するメーカーはSamsung 8 nm(改良型10 nm)から、TSMC 4N(TSMC 5 nm)プロセスに変更されました。高い電力効率、高いトランジスタ密度、優れた高クロック耐性に期待できます。

大幅に巨大化した設計規模(283億 → 763億トランジスタ)にも関わらず、消費電力の目安を示すTGPは約30%多い450 Wで済んでいます。TSMC 4Nプロセス様々です。

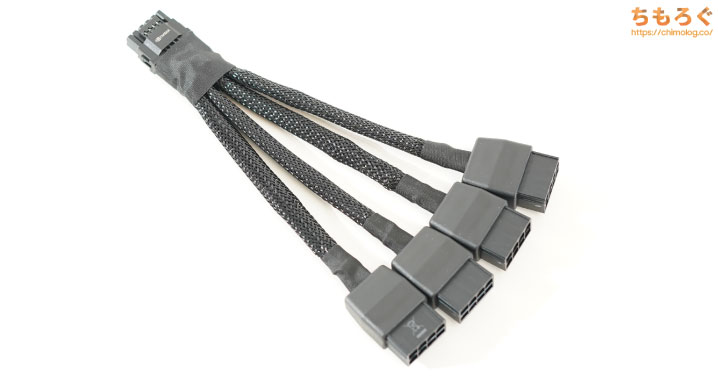

補助電源コネクタは従来の「8 pin」から、「16 pin(12VHPWR)」に切り替えられています。

発売初期のコネクタ溶解騒ぎのせいで「怖い」イメージを抱かれている気がするので、コネクタの定格給電能力を雑に計算してみましょう。

- 8 + 8 pin(二股)コネクタ:約274 W

- 二股コネクタを2本束ねる:約548 W

- 12VHPWRの場合:約618~629 W

計算した定格給電能力を見る限り、それほど危険性は無いです。NVIDIAが公式に「しっかり挿し込め」と指摘している程度ですが、従来のPCIe 8 pinもしっかり挿し込まないと危険です。

そもそも似たような形状の12 pinコネクタが先代のRTX 3090 Ti等で先行導入されており、目立った問題が起きていません。

8 + 8 pin(二股)コネクタの場合、8本の電線のうち3本が+12Vです。ATX規格で許容される最低規格値は11.4 Vなので、合計電圧が34.2 Vと計算できます。

ここに電流を掛けると、定格給電能力を求められます。一般的な電源ユニットで使われる16 AWGケーブルであれば、電流は8 Aで273.6 Wです。一部のSeasonic電源で使われる18 AWGなら電流7 Aで239.4 Wです。

12VHPWRでは、16本の電線のうち6本が+12Vです。ATX v2.x電源に12VHPWR変換コネクタを挿し込んで使うなら、6本 x 11.4 V x 9.2 Aで629.28 Wを求められます。

ATX 3.0対応電源なら6本 x 11.2 V x 9.2 Aで618.24 Wと計算できます。

なお、上記の給電能力は補助電源コネクタのみで、PCIe x16スロットから最大75 Wの給電も可能です。従来の二股コネクタを2本束ねて実質600 W台まで、12VHPWRなら実質700 W近くまで対応できる計算に。

RTX 4090のTGPは出荷設定で450 Wです。12VHPWRケーブル1本でまったく不足なし。ただし、600 Wをゆうに超えるであろう競技OC目的の方は、GALAX HOFシリーズなど12VHPWRを2本備える特殊仕様のAIBモデルを使ってください。

なお、筆者は極めて個人的な理由で「12VHPWR」推しです。

一度使ってみれば理解できますが、もうとにかく便利です。PCIe 8 pinを2個以上搭載するグラフィックボードなら、例外なく12VHPWRを導入して欲しいくらいに気に入っています。

Radeon RX 7000シリーズも変な意地を張らずにぜひ12VHPWRコネクタを。グラボを何度も交換する検証が趣味の筆者にとって、これほど明確に利便性を感じたPCパーツは久々です。

なお、従来の電源ユニットを接続できないように見えますが、ちゃんと8 pinから16 pinに変換するコネクタが付属します。変換コネクタを使えば、従来の電源ユニットをそのまま接続可能です。

RTX 4090では、変換コネクタを3本(450 Wモード)または4本(600 Wモード)接続すると従来の電源ユニットで正常に機能します。

「ATX 3.0」「PCIe 5.0」対応などとアピールする、スペックや性能の割に価格が妙に高い電源ユニットをわざわざ買う必要はありません。

CorsairやThermaltakeが単品で販売している「12VHPWR変換アダプタ」を使うのも手です。実際に筆者はCorsair HX850i 2021に、Corsair製のアダプタを接続してRTX 4090を運用しています。

RTX 4090のMSRPは1599ドルです。値段だけ見ると決して安いと思えませんが、RTX 4090のチップ面積は608 mm2とかなり大きく、面積が半分近いRTX 4080が1199ドルを請求していると考えれば「安い」と感じます。

- RTX 4090(608 mm2):1599ドル

- RTX 4080(379 mm2):1199ドル

- RTX 4070 Ti(295 mm2):799ドル

RTX 4080はRTX 4090より約40%小さい面積で、請求金額が約25%しか下がっていません。RTX 4070 TiはRTX 4090より約51%小さく、請求金額もほぼ半額です。

つまりRTX 4080のMSRPは明らかに暴利で、買うならRTX 4090の方がお買い得に見えます。

製造に使われた「TSMC 4N(TSMC 5 nm相当)」のウェハ単価を考慮すると、一応RTX 4080のMSRPにそれらしい理由付けが可能ですが、ウェハ単価に根拠を求めると今度はRTX 4090の値付けを説明できません。

・・・RTX 4080だけ妙にボラれている説が濃厚です。

RTX 4090の性能をベンチマーク比較

| テスト環境 「ちもろぐ専用ベンチ機(2023)」 | ||

|---|---|---|

| Core i9 13900K24コア32スレッド | ||

| NZXT Kraken X63280 mm簡易水冷クーラー | ||

| ASUS TUF GAMINGZ690-PLUS WIFI D4 | ||

| DDR4-3200 16GB x2使用メモリ「Elite Plus UD-D4 3200」 | ||

| GIGABYTE RTX 4090 GAMING OC 24G | ||

| NVMe 1TB使用SSD「FireCuda 520」 | ||

| 850 W(80+ Platnium)使用モデル「Corsair HX850i」 | ||

| Windows 11 Pro検証時のバージョンは「22H2」 | ||

| ドライバ | NVIDIA 531.61 | |

| ディスプレイ | 3840 x 2160@144 Hz使用モデル「INNOCN 32M2V」 | |

「RTX 4090」を比較するために用意した専用PCスペックです。

CPUにゲーミング性能でトップクラスの「Core i9 13900K」を使います。メモリは普通のDDR4-3200(ネイティブ)で容量32 GBで、テスト時のドライバは「531.61」です。

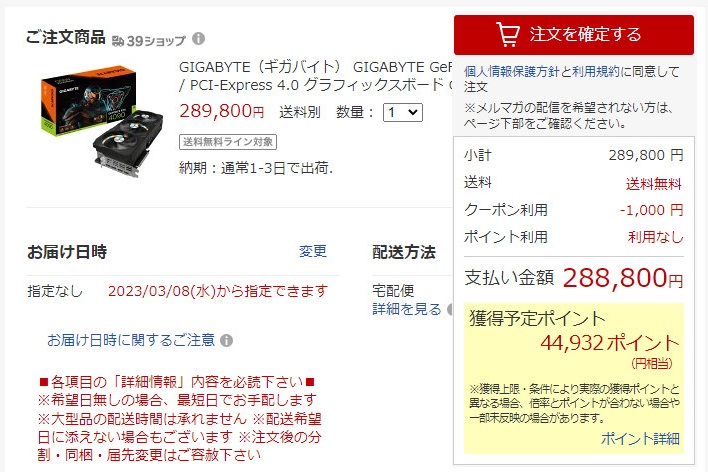

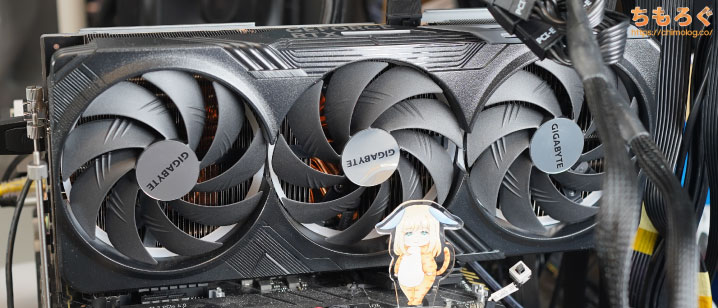

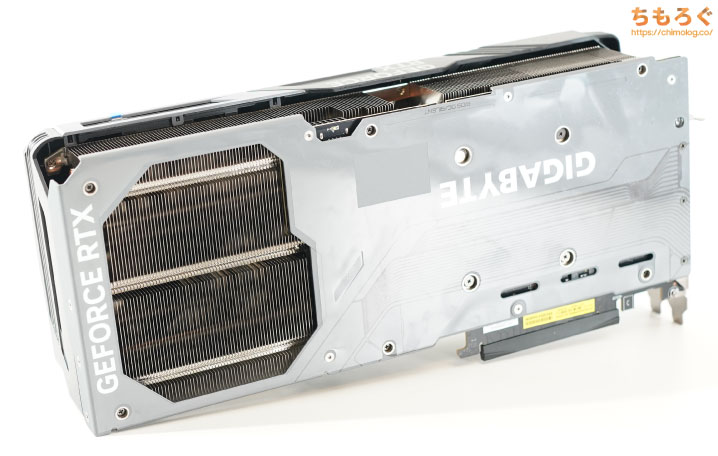

テスト用のRTX 4090は「GIGABYTE RTX 4090 GAMING OC 24G」を使います。

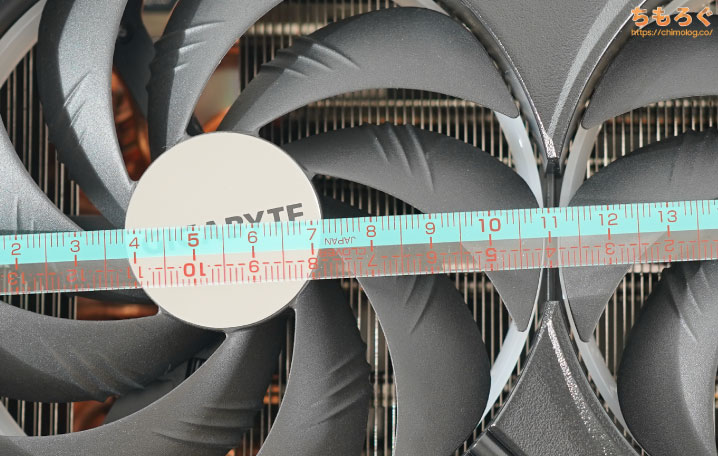

全長340 mm、厚み75 mm(4スロット占有)の巨大な設計、ベイパーチャンバー構造と8本のヒートパイプを内蔵する割に価格が安いので選んでみました。

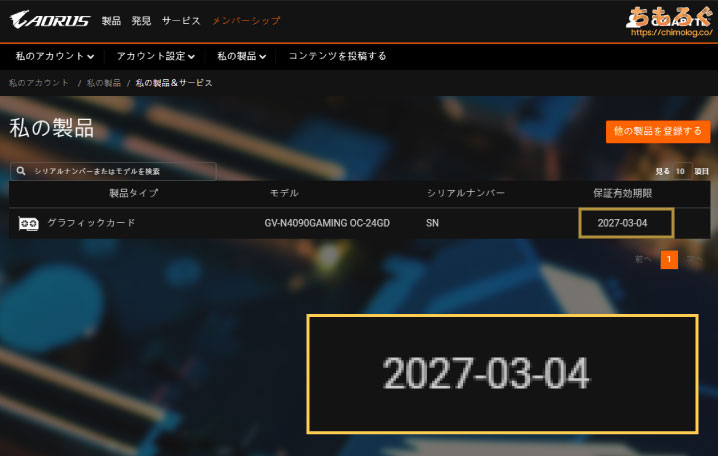

国内で4年保証がついてくる点も大きな魅力です。購入から30日以内に公式サイトから製品登録をすると、通常2年保証に加えて2年の延長保証が付与されます。

うっかり並行輸入品を掴まされないように、楽天に出店しているJoshin webで購入しました。Amazonの約4~5倍は美味しいポイント還元も購入を後押しするきっかけに・・・。

競技FPS:VALORANTなど

まずは競技性が重視されるFPSゲームで、設定別にフレームレート(性能)を比較しました。

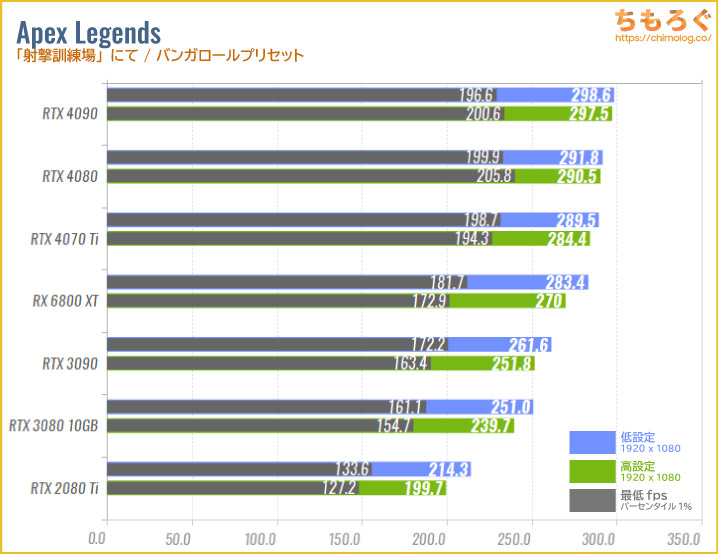

Apex Legendsの「低設定」「高設定」で比較したグラフです。

RTX 4080と同じく、RTX 4090も性能が良すぎて300 fps上限にぶつかってしまいます。最低フレームレートの落ち込みも大差無いです。

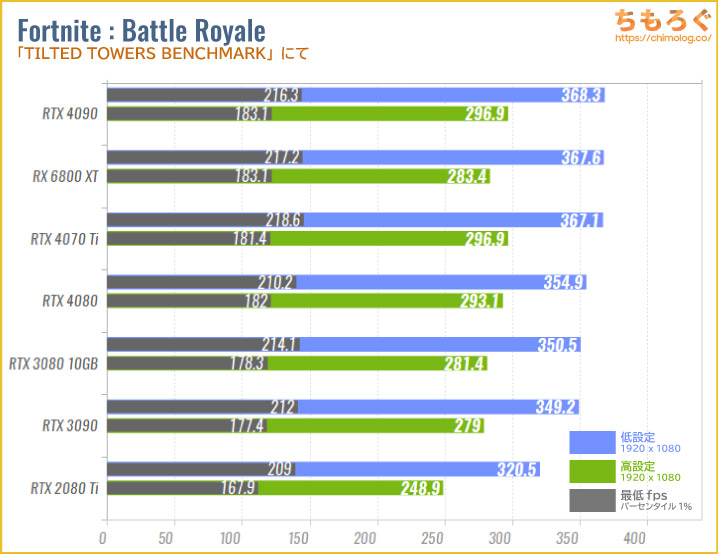

フォートナイトの「中設定」「高設定」で比較したグラフです。

低設定は350~360 fps前後、高設定だと280~290 fps前後で頭打ちです。最近のハイエンドクラスだと、Core i9 13900KですらCPUボトルネックになり、グラボ側の性能を引き出すのが難しいです。

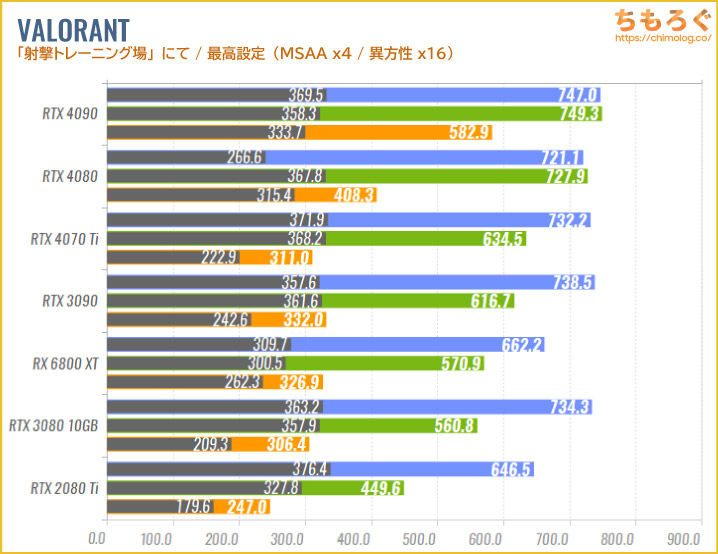

競技FPSの代表的タイトル、VALORANTを最高設定で比較したグラフです。

RTX 4090はフルHDとWQHDで平均700 fpsを超え、CPUボトルネックに阻まれて頭打ちに。4K解像度で比較するとRTX 3090に対して約76%もの性能アップが見られます。

Apex Legends

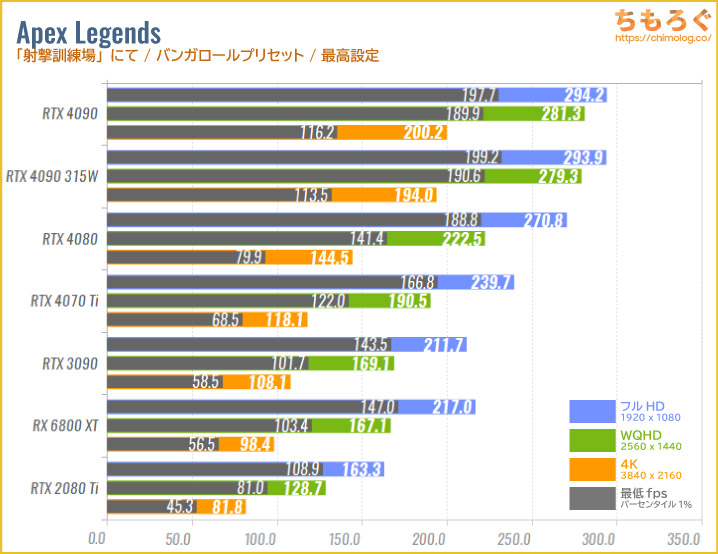

Apex Legendsを最高設定で比較したグラフです。

すべての解像度でRTX 4090が最高の性能を示します。RTX 3090に対してフルHDで約39%、WQHDで約66%、4Kで約85%もの圧倒的な性能アップを遂げています。

Apex Legends(4K最高画質)を平均200 fps前後で動かせる唯一のグラボです。

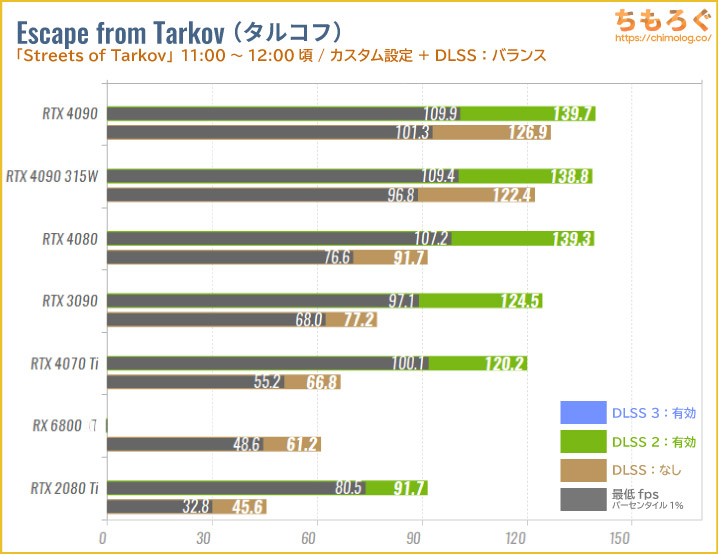

Escape from Tarkov(タルコフ)

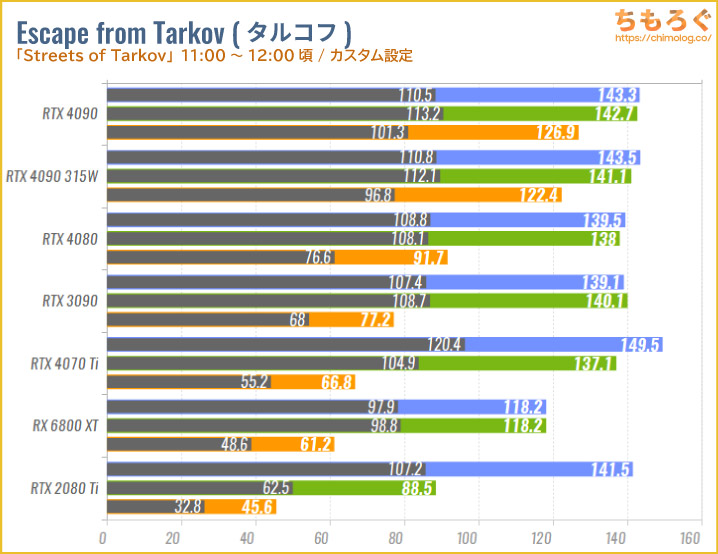

Escape from Tarkov(タルコフ)の重たいマップ、Streets of Tarkovで比較したグラフです。

設定はタルコフYoutuber「らっしーRushy_ve」さんを参考に、SSRをオフにしたり、Reflex Low Latencyをboost onにするなど、やや高画質な競技設定(→ 設定画面はこちら)を使用しました。

フルHDとWQHDはCPUボトルネックの影響で頭打ちですが、4K解像度でハッキリと性能差を示します。RTX 3090に対してRTX 4090が約65%も高性能で、315 Wに制限した状態でも約58%高性能です。

Overwatch 2

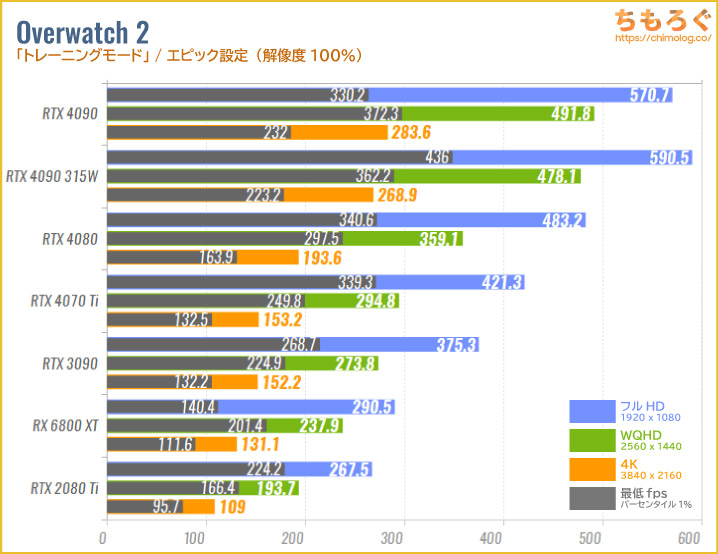

オーバーウォッチ2をエピック設定(解像度100%)で比較したグラフです。

グラフィックボードの性能が反映されやすいゲームです。すべての解像度でRTX 4090が最高のフレームレートを示し、315 W制限ですら圧倒的な性能を維持します。

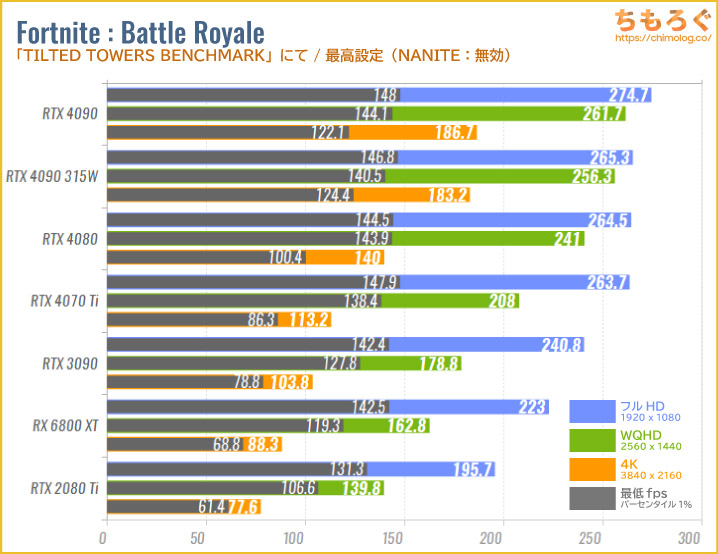

Fortnite(フォートナイト)

フォートナイトを最高設定(NANITE:無効)で比較したグラフです。

RTX 4090はフルHDとWQHDでCPUボトルネックに阻まれて頭打ちに。4K解像度で平均187 fpsを叩き出し、RTX 3090に対して約80%もの性能アップです。

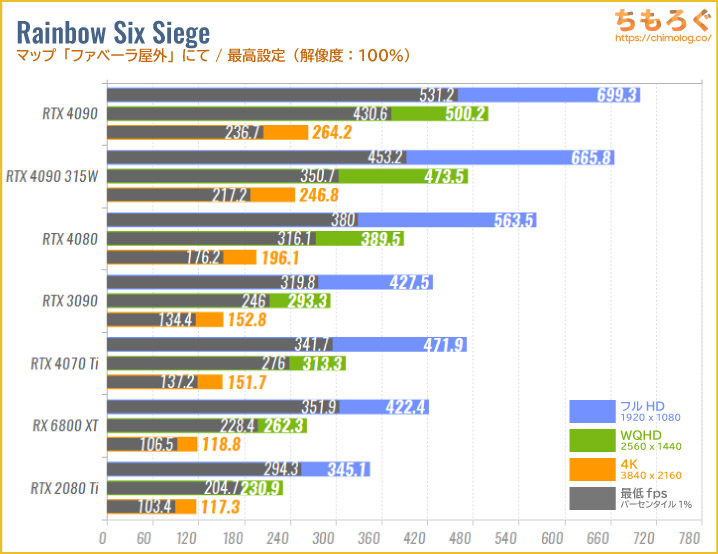

R6S(レインボーシックスシージ)

レインボーシックスシージを最高設定、マップをファベーラにて比較したグラフです。

意外とGPUに負荷がかかりやすいゲームで、フルHDでも性能差がハッキリと出ます。すべての解像度でRTX 4090が最高のフレームレートで、4K解像度においてRTX 3090に対して約73%の性能アップです。

まだ国内で展開されていない240 Hz対応4Kゲーミングモニターをフルに活用できる性能です。

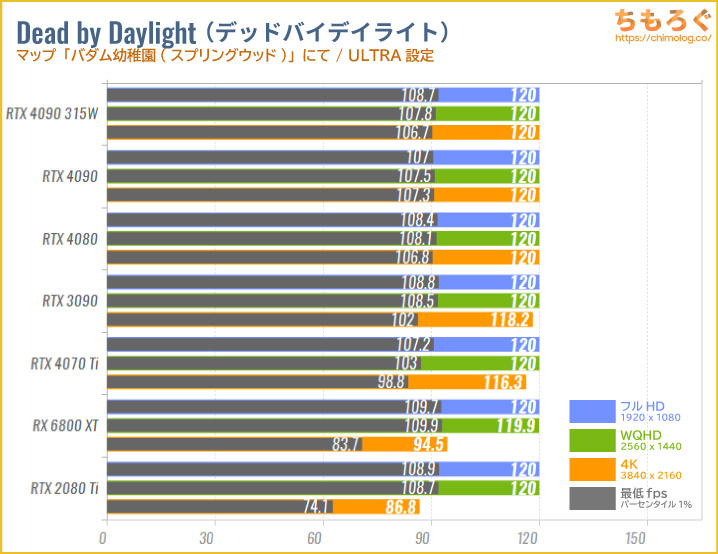

Dead by Daylight(デドバ)

デッドバイデイライトをULTRA設定、マップ「バダム幼稚園」で比較したグラフです。

見ての通り、RTX 4090はフルHDから4Kすべてでフレームレート上限120 fpsに衝突します。120 fps上限がなかった場合、平均200 fps前後を予想できます。

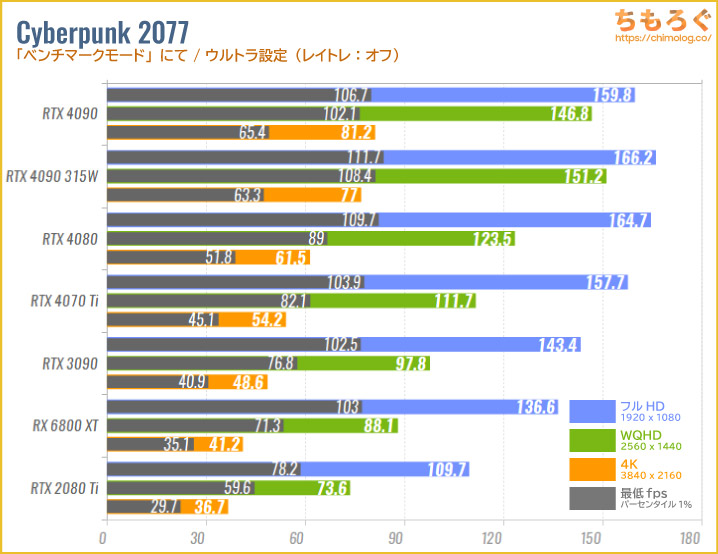

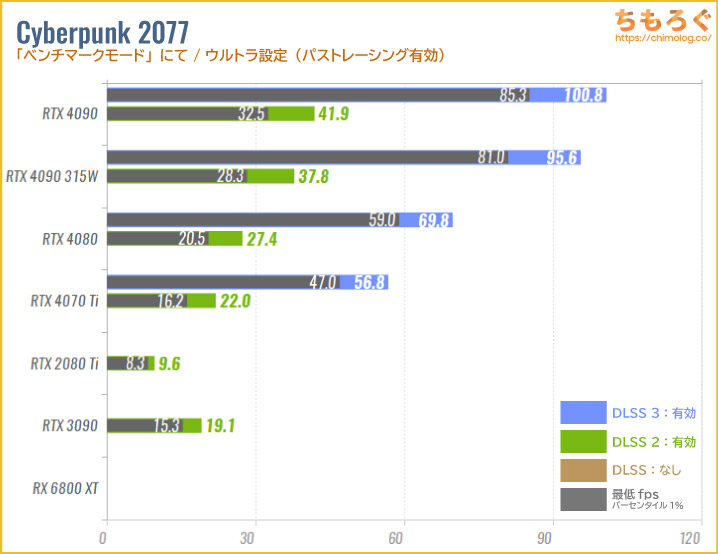

Cyberpunk 2077

重量級ベンチマークの代表例「サイバーパンク2077」をウルトラ設定(レイトレなし)で比較したグラフです。

RTX 4090はNVIDIA DLSSを使わず、ネイティブ4Kで平均60 fpsを大きく超えます。315 W制限でも平均60 fpsを維持できます。前世代から約57~65%の性能アップです。

サイバーパンク2077は「DLSS 3(フレーム生成)」に対応しているため、RTX 4090にはまだまだ性能を伸ばせる余地が残されています。

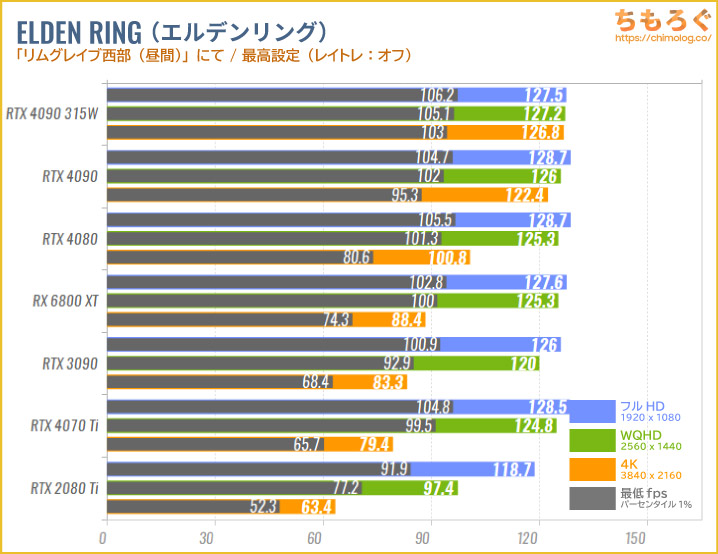

エルデンリング

エルデンリングを最高設定で比較したグラフです。

CPUボトルネックの影響でフルHDは130 fps前後で頭打ち、WQHDも平均125 fpsあたりで頭打ちの傾向が見られます。

4K解像度で性能の伸びが見られますが、CPUボトルネックに阻まれて平均125 fps前後にとどまります。RTX 3090に対して約53%の性能アップです。

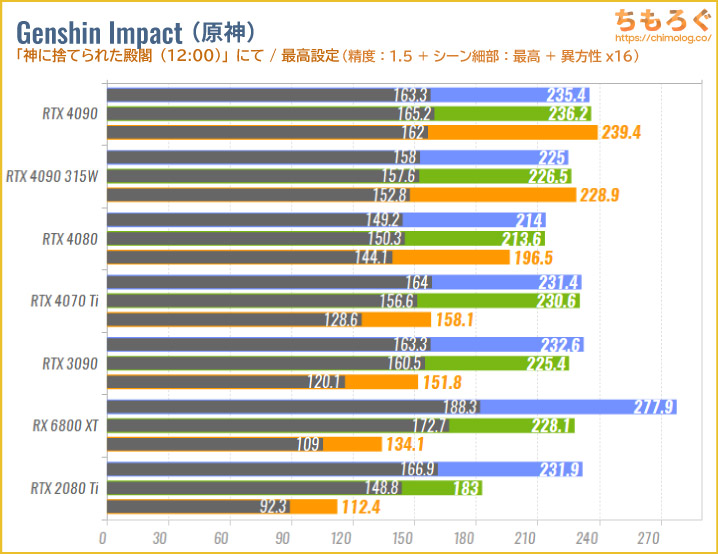

原神(Genshin Impact)

原神を最高設定(精度:1.5 / シーン細部:最高 / 異方性x16)で比較したグラフです。

以前のレビューで使っていたマップ「スメールシティ」はCPUボトルネックが深刻だったため、今回のテストからGPUに負荷がかかりやすい「神に捨てられた殿閣」に変更します。

4K解像度ならRTX 4090ですらGPU使用率が95%前後に達し、ほとんどのGPUで性能比較を成立させられます。

ではRTX 4090の性能を確認します。フルHDとWQHDはCPUボトルネックで頭打ちになり、4K解像度で本領発揮です。RTX 4090に対して約57%の性能アップです。

315 W制限でも平均230 fps前後で圧倒的トップに。

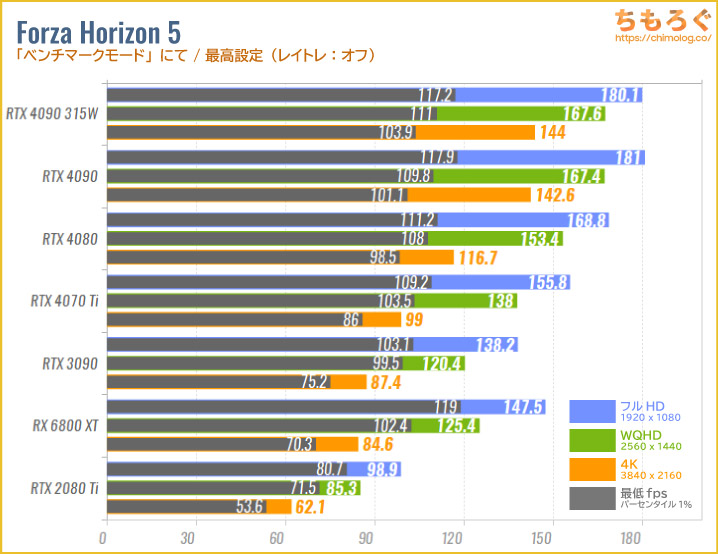

Forza Horizon 5

Forza Horizon 5を最高設定(レイトレなし)で比較したグラフです。

付属のベンチマークを使っているため、性能差がきれいに反映されます。Forza Horizon 5はRTX 4000シリーズやRadeon(RDNA)シリーズが得意な傾向です。

RTX 4090とRTX 3090の性能差を順番に見ていくとフルHDで約31%、WQHDで約39%、4K解像度で約65%も高性能でした。

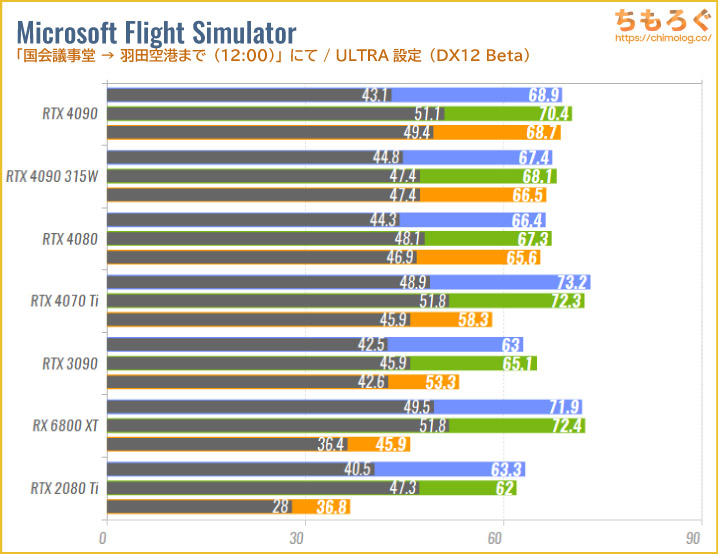

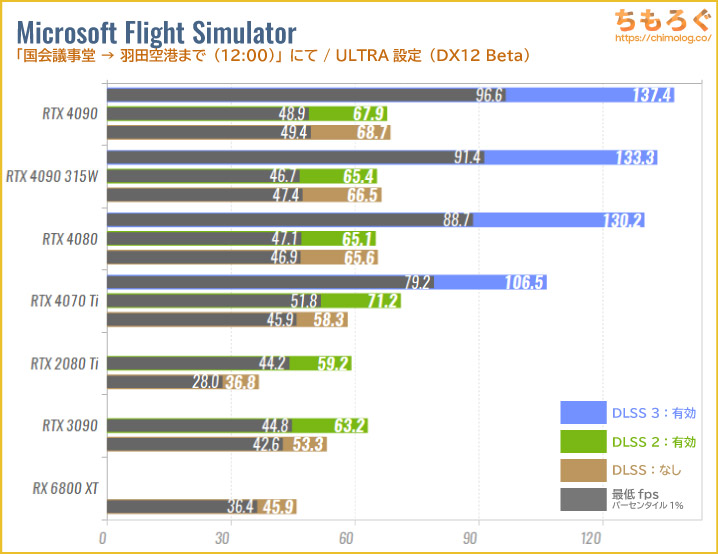

Microsoft Flight Simulator

MSFS(Flight Simulator)をUTLRA設定で比較したグラフです。

フルHDとWQHDではもっぱらCPUボトルネックの影響が大きく、あまり性能比較になっていません。

4K解像度なら負荷がかかりやすいものの、RTX 4080あたりでCPUボトルネックに衝突します。CPUボトルネックを大幅にカットする「DLSS 3(フレーム生成)」が前提のゲームタイトルです。

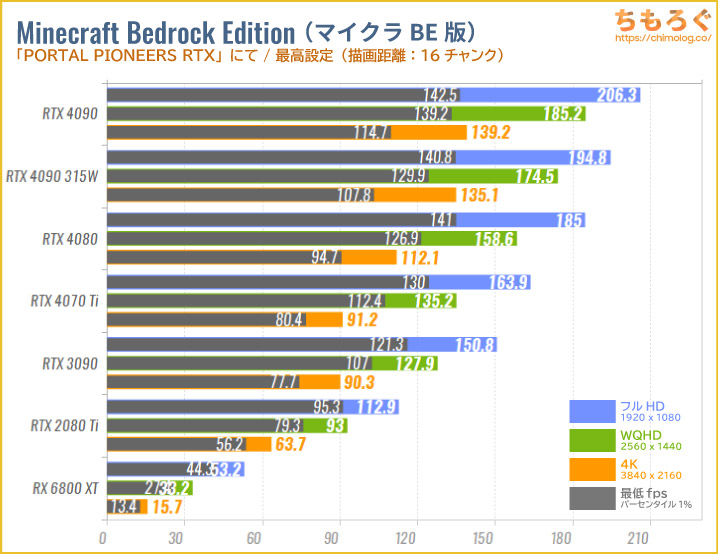

マインクラフトBE版

Java版より最適化が洗練されているマインクラフトBE版を、最高設定(16チャンク読み込み)で比較したグラフです。

4K解像度でRTX 4090がRTX 3090より約50%も高性能です。

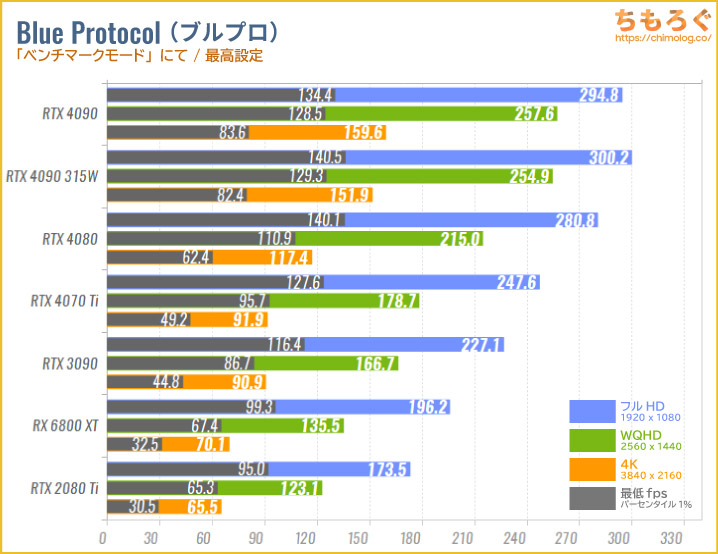

ブループロトコル

MMORPGブループロトコルを最高設定で比較したグラフです。

フルHDとWQHDは割りと順当に性能が伸びますが、4K解像度ではVRAM帯域幅の影響も出ます。RTX 4090はRTX 3090よりもVRAM帯域幅が多く、約76%もの性能差で完封します。

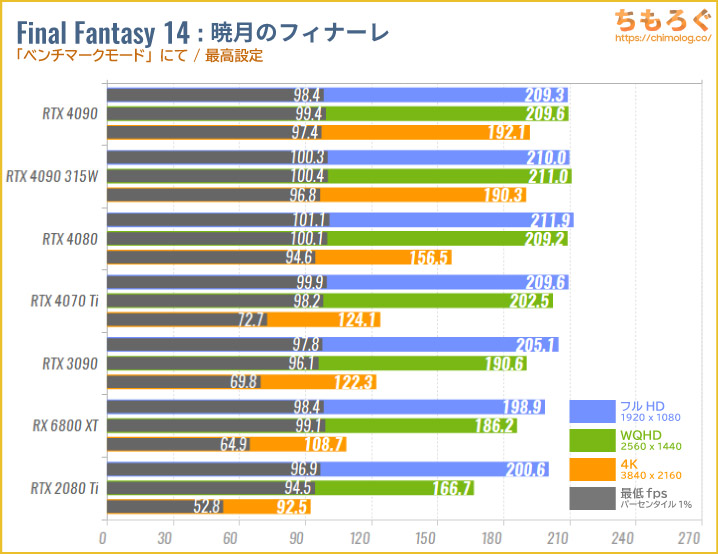

FF14:暁月のフィナーレ

GPUベンチマークとしては不適切な・・・、FF14:暁月のフィナーレを最高設定で比較したグラフです。

なお、フレームレートが極端に跳ね上がる中盤以降をカットしたデータです。CPUボトルネックの影響でフルHDとWQHDでほぼ性能差が出ませんが、4K解像度だとRTX 4090が約57%もの性能差でRTX 3090を圧倒します。

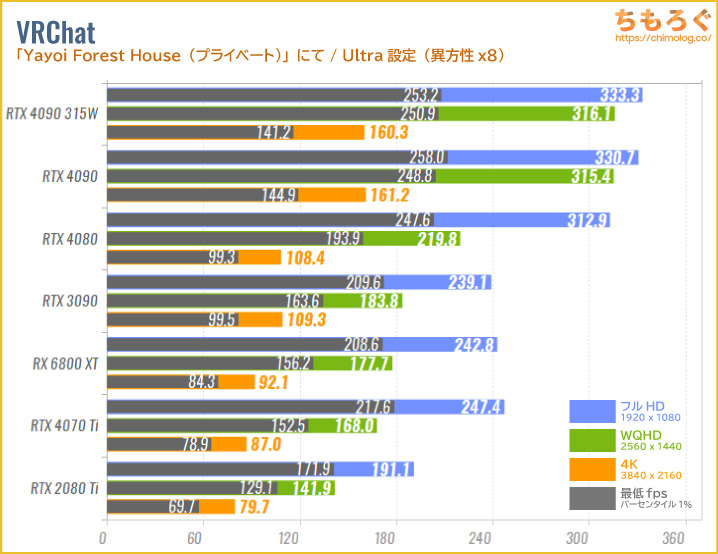

VRChat

VRゲームの代表例でありながら、ベンチマークをほとんど見かけないVRChatを比較したグラフです。

グラフィック設定をUltra設定(異方性 x8)に、フレームレート上限を解除して、「Yayoi Forest House(作:猫屋敷やよい さん)」のプライベートモードで測定しました。

GPU使用率が100%になりやすいマップを選んでいるため、GPUの性能比較として機能します。

あまり意味のないフルHDとWQHDは無視するとして、実際のVR HMD環境に近い4K解像度において、RTX 4090はRTX 3090より約48%も高性能です。

片眼5K相当のVR HMDを使った検証では2倍近い性能差も見当たり、高解像度になればなるほど約16000シェーダーを抱えるRTX 4090が高い性能を示す可能性が高いです(当たり前)。

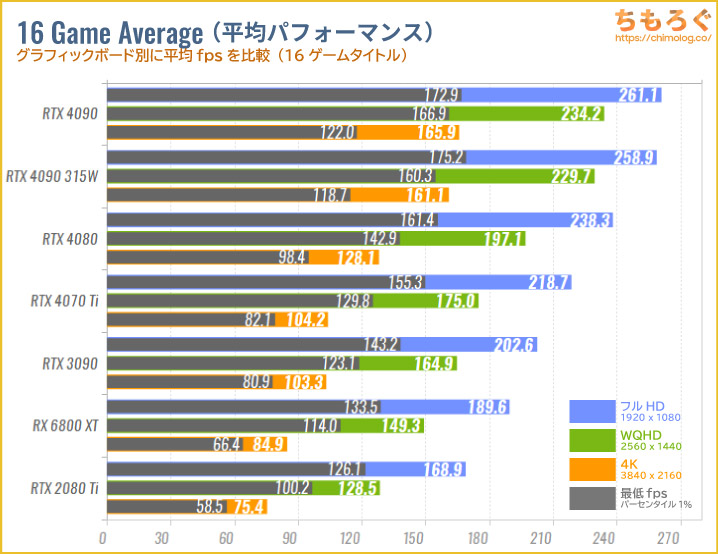

16ゲームの平均フレームレート

テストしたゲームの平均フレームレートをまとめました(※注意:平均はしょせん平均なので参考にしすぎないように)。

今回テストした内容だと、RTX 4090はRTX 3090に対してフルHDで約29%、WQHDで約42%、4K解像度で約61%も高性能です。

パワーリミット70%(315 W制限時)では、RTX 3090(定格350 W)に対してフルHDで約28%、WQHDで約39%、4K解像度で約56%高性能です。

現状、最高峰のゲーミング性能と評価できます。

CPUボトルネックの影響でRTX 4090のフルパワーを引き出すのが困難なため、パワーリミット(消費電力の制限)による性能低下も非常に少ないです。

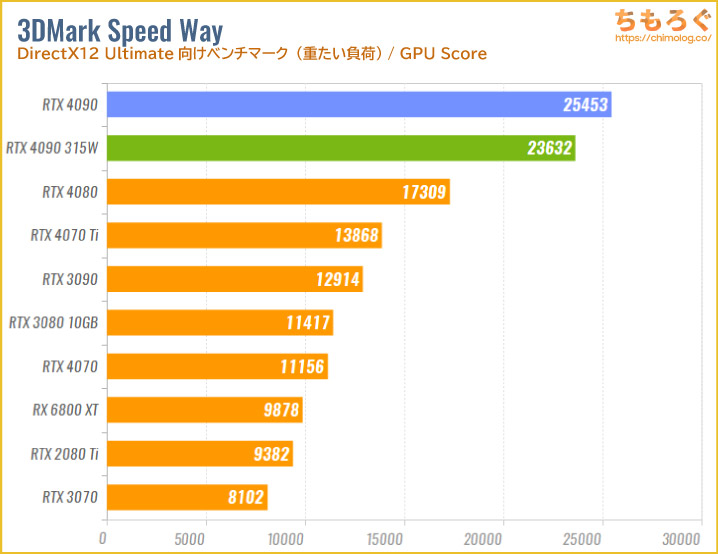

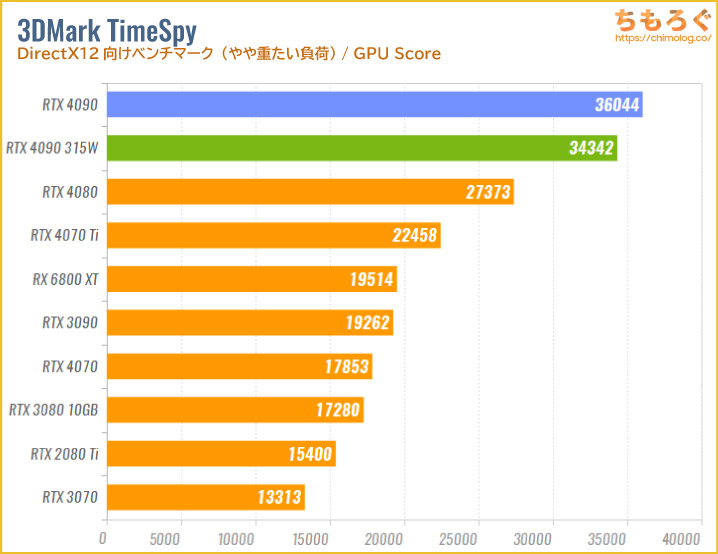

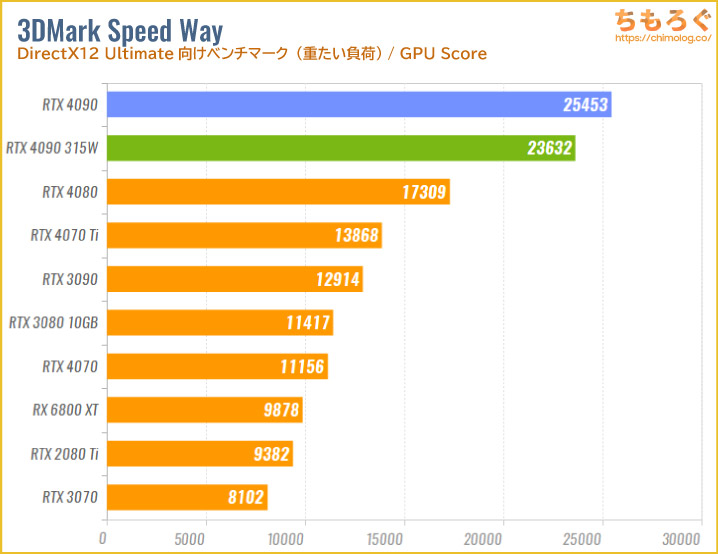

グラフィックボード用の理論値ベンチマーク「3DMark Speed Way」のテスト結果が以下です。

最大消費電力を450 Wから315 W(70%)にカットすると、GPUスコアが約8%下がります。GPU使用率が100%に張り付く環境でも、30%カットした程度なら性能の落ち込みは1割くらいで済みそうです。

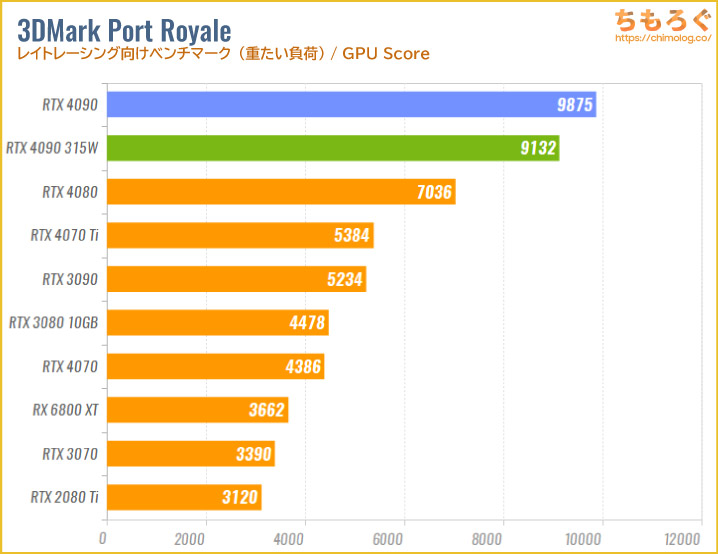

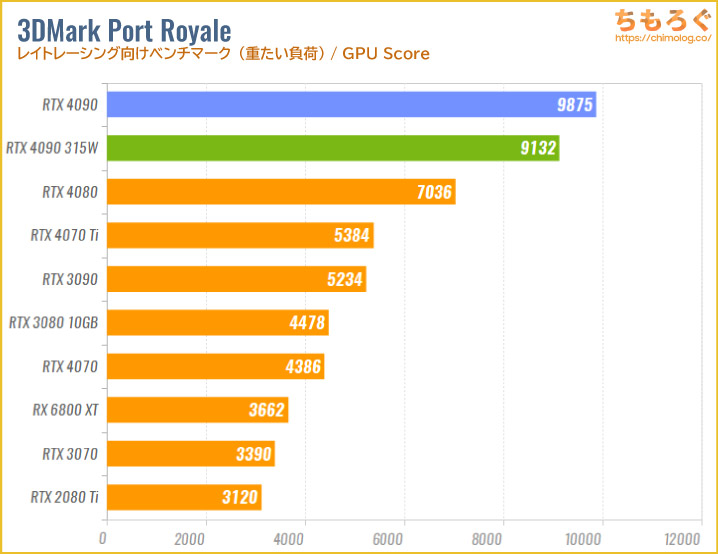

こちらも理論値ベンチマークで有名な「Port Royale」の結果です。GPUスコアは約8%下がっただけです。RTX 3090より少ない消費電力で、はるかに多い仕事量をこなせます。

fpsを底上げ「DLSS」を使った結果

- フルHDでいったんレンダリング

- 機械学習を使って4Kにアップスケーリング

- 実質4Kのフレームが完成します

4K解像度のレンダリングは非常に重たい作業ですが、DLSSを使えばフルHDやWQHD相当のレンダリングで済ませられるので、フレームレートを稼ぎやすくなります。

ちなみに、どの程度の解像度でレンダリングするかどうかはゲーム側の設定で調整できます。高画質な設定ならWQHD相当で、性能重視な設定だとフルHDやHD相当でレンダリングを行います。

RTX 4000シリーズは、コア内部に搭載された機械学習に特化した「Tensor」コアを用いて、高画質なアップスケーリングを用いたフレームレート底上げ機能「DLSS」を利用できます。

今回はDLSS 2以上に対応している3本のゲームで、DLSSの効果をテストしました。

タルコフ(4K解像度)でDLSSを使った結果、フレームレートが1割増加するだけでした。

DLSS 2.xはネイティブ解像度より小さい解像度でレンダリングをします。タルコフのようにCPUボトルネックが発生しやすいゲームだと、CPUボトルネックの影響を避けられません。

フレームをGPU側で作り出す「DLSS 3」ならCPUボトルネックを大幅にカットできますが、残念ながらタルコフがDLSS 3にまだ非対応です。

サイバーパンク2077(4K解像度 + パストレーシングモード)では、DLSS 2だけだとマトモに・・・RTX 4090なら割と動作します(動揺。

RTX 4000シリーズでのみ使えるDLSS 3(フレーム生成)を有効化すると、フレームレートが約2.4倍に跳ね上がって平均100 fpsに。

315 Wに制限した状態でも平均96 fpsを叩き出し、RTX 4080を圧倒。もちろん、DLSS 3に対応しない先代RTX 3090との性能差は「5倍」に開きます。

NVIDIAのトップ革ジャン氏が「4倍」だの「5倍」などと非現実的な数字をアピールした場合、基本的にDLSS 3を使った状態との比較と考えましょう。

CPUボトルネックが深刻でフレームレートを伸ばしづらいMSFSも、GPU側でフレーム生成が済むDLSS 3(フレーム生成)なら効率よくfpsを伸ばせます。

と思いきや、どうやら平均140 fps手前でCPUボトルネックの影響が見受けられます。元フレームに対する伸び率を見ると、およそ2倍です。

元フレーム側のレンダリングにはCPUボトルネックが存在するため、DLSS 3にも限界があります。

- A Plague Tale: Requiem

- Atomic Heart

- Bright Memory: Infinite

- Cyberpunk 2077

- Conqueror’s Blade

- Dakar Desert Rally

- Deliver Us Mars

- Destroy All Humans! 2 – Reprobed

- Dying Light 2

- F1 22

- FIST: Forged In Shadow Torch

- Forza Horizon 5

- Hitman: World of Assassination

- Hogwarts Legacy

- Jurassic World Evolution 2

- Justice

- Loopmancer

- Marvel’s Midnight Suns

- Marvel’s Spider-Man: Miles Morales

- Marvel’s Spider-Man Remastered

- Microsoft Flight Simulator

- Mount & Blade II: Bannerlord

- Need For Speed Unbound

- Perish

- Portal with RTX

- Sackboy: A Big Adventure

- The Witcher 3: Wild Hunt – Game of the Year Edition

- Warhammer 40,000: Darktide

- WRC Generations

- Black Myth: Wukong

- Chernobylite

- Diablo IV

- Icarus

- Marauders

- Midnight Ghost Hunt

- Naraka: Bladepoint

- Ripout

- STALKER 2: Heart of Chornobyl

- Scathe

- Super People 2 (available now in early access)

- Sword and Fairy 7

- Synced

- The Cycle: Frontier

- The Day Before

- The Finals

- The Lord of the Rings: Gollum

- Throne and Liberty

- Tower of Fantasy

- Warhaven

- Witchfire

2023年3月時点、上記の50タイトルがDLSS 3.0に対応する予定です。

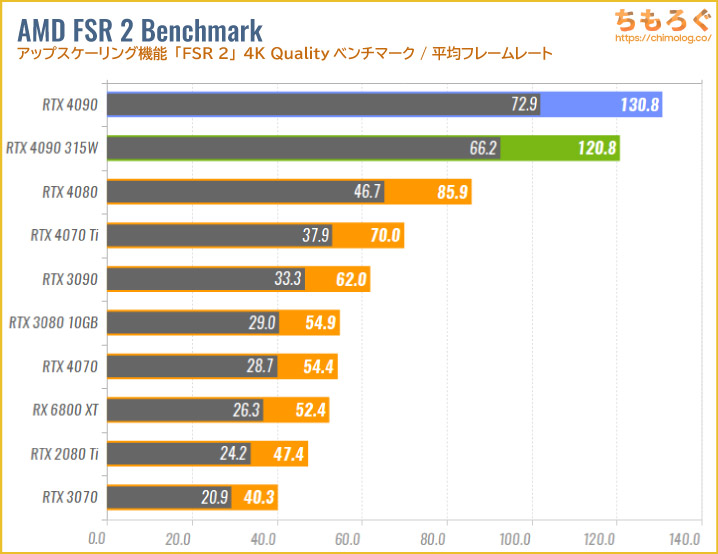

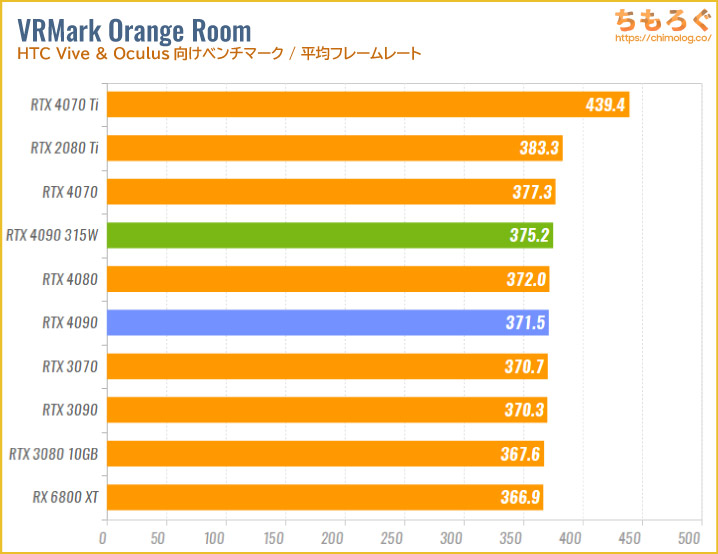

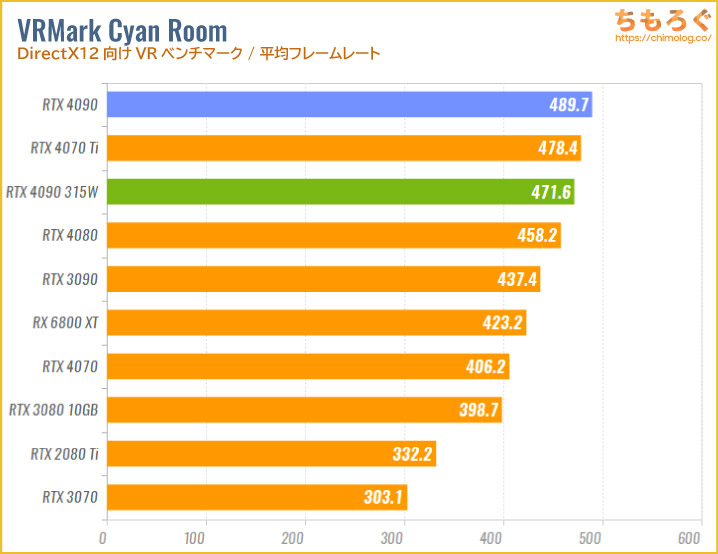

3DMark等の定番ベンチマークに興味がないので説明は省きます。

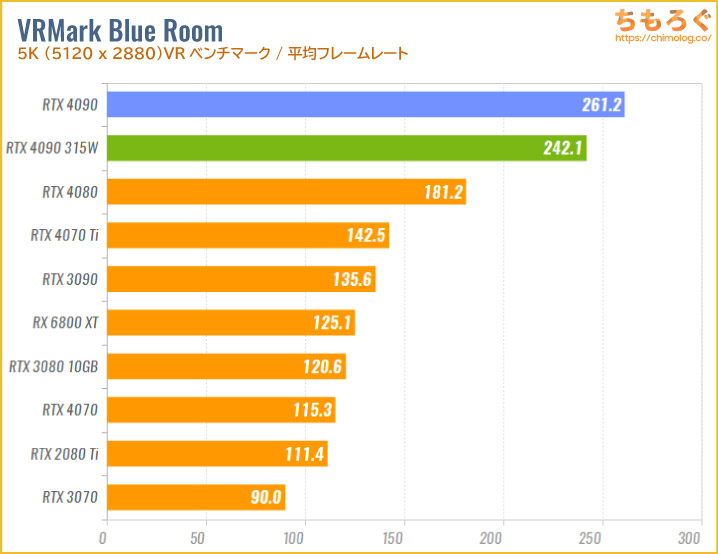

理論値ベンチマークにおいて、RTX 4090は最高のスコアです。

VRMark Blue RoomやAMD FSR 2 Benchmarkなど、RTX 3090に対して約2倍の伸び幅が見られるベンチマークもあります。

RTX 4090のクリエイティブ性能を比較

| GPU | RTX 4090 | RTX 3090 |

|---|---|---|

| シェーダー数CPUのコア数に相当 | 16384 | 10496 |

| ブーストクロック | 2520 MHz | 1695 MHz |

| VRAM | GDDR6X 24 GB | GDDR6X 24 GB |

| 理論性能(FP32) | 82.58 TFLOPS | 35.58 TFLOPS |

グラフィックボードのクリエイティブ性能は基本的に、シェーダー数(※厳密にはFP32コア数)とクロック数から計算できる理論性能(FP32)に比例して高くなる傾向があります。

RTX 4090の理論性能を求めると約82.6テラフロップス、RTX 3090は約35.6テラフロップスで、RTX 4090に期待されるクリエイティブ性能は約2.3倍です。

実際に2.3倍もの性能を得られるか、いくつか試して確認しましょう。

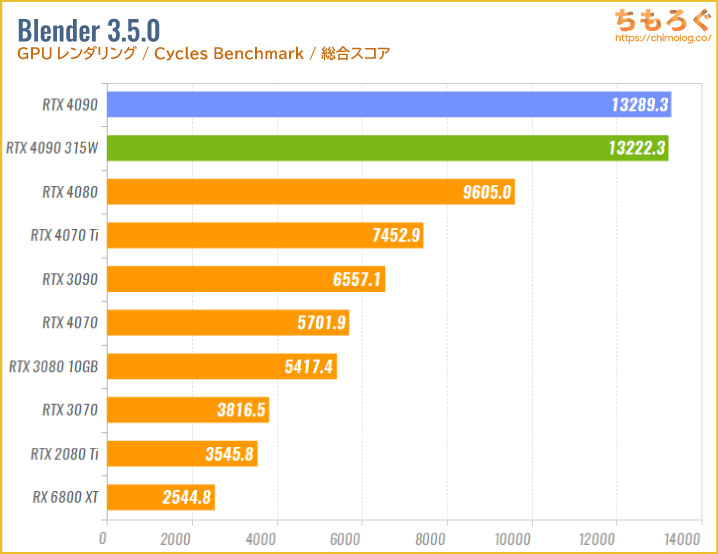

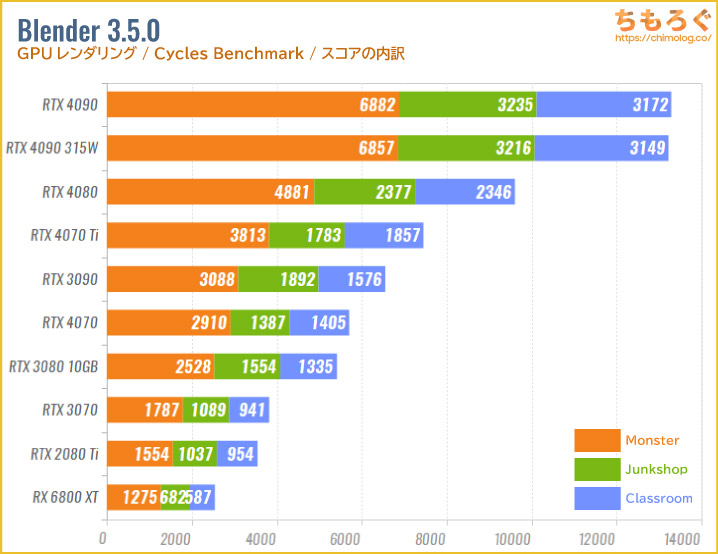

GPUレンダリング(Blender)

GPUレンダリングの定番ベンチマーク「Blender 3.5.0」では、RTX 4090がRTX 3090に対して+103%もの性能(約2倍)を記録します。

100ドルの値上げで約2倍のレンダリング性能を可能に。3Dクリエイターにとって文句なしにコストパフォーマンスに優れたグラボです。

スコアの内訳(Monster / Junkshop / Classroom)はそれぞれ以上のとおりです。

どのプロジェクトを見てもRTX 4090が抜きん出たスコアを示します。

画像のAIアップスケーリング

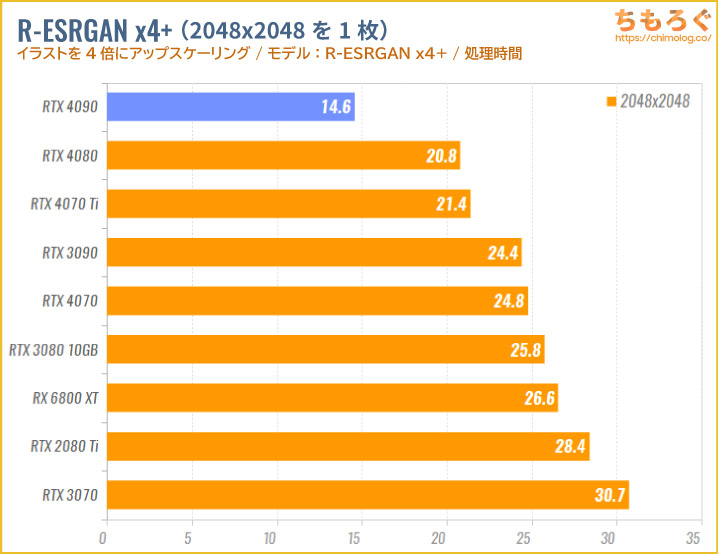

AI(機械学習)を用いた画像のアップスケーリングをテストします。

シェアウェアだとTopaz Gigapixel AIが有名ですが、今回は無料で使えるStable Diffusion Web UIのExtrasから「R-ESRGAN x4+」を使って、画像の4倍超解像を試しました。

2048 x 2048 pxの4倍アップスケーリングは14.6秒を要し、RTX 3090より約67%速く終わります。

AIイラスト(Stable Diffusion)

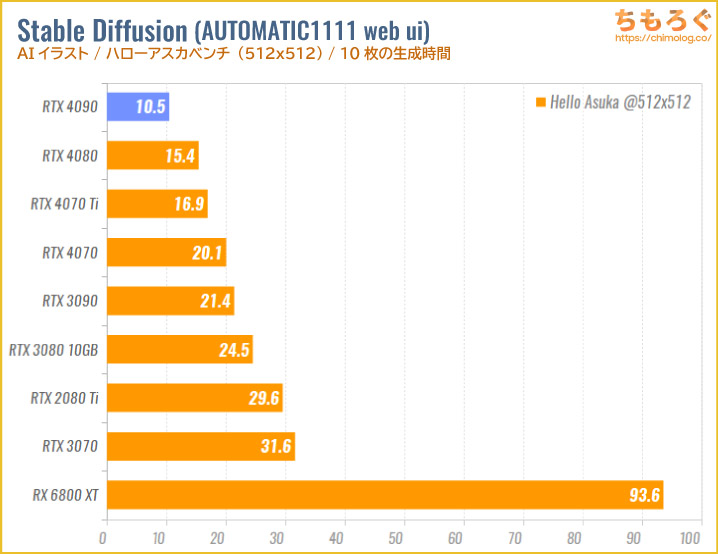

AIイラストの定番ソフト「Stable Diffusion(AUTOMATIC1111 web ui版)」を使って、AIイラストの生成時間を比較します。

使用するベンチマーク内容は以下のガイド記事より3点です。

- ハローアスカベンチ(512 x 512)

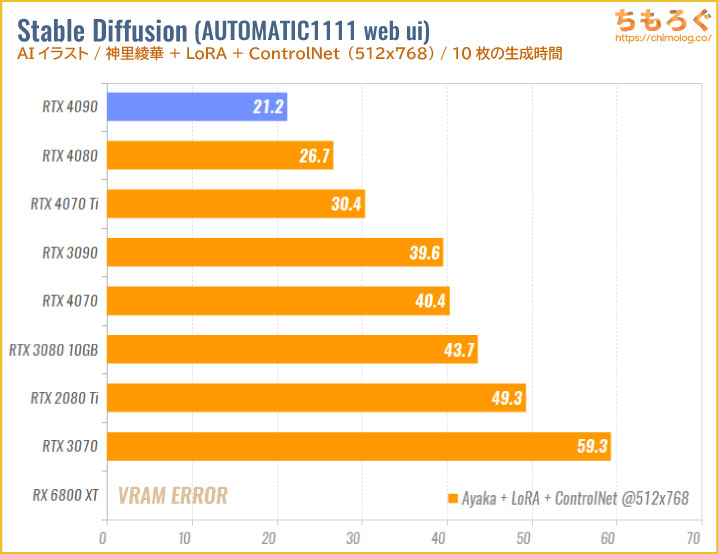

- 神里綾華(LoRA + ControlNet)ベンチ(512 x 768)

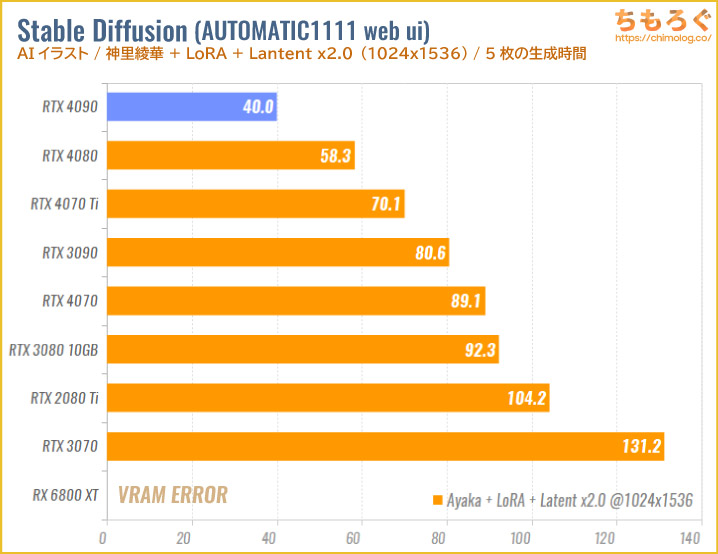

- 神里綾華(LoRA + Latent x2.0)ベンチ(1024 x 1536)

生成時間が短いほど高性能です。

GeForceシリーズはCUDA版(RTX 4000のみtorch 2.x + xformer v17)、Radeon RXはDirectML版のStable Diffusion web uiを使ってテストします。

ハローアスカベンチ(10枚分)の生成時間は、RTX 4090が10.5秒、RTX 3090が21.4秒でした。ほぼ2倍のスピードでAIイラストを生成できます。

VRAM容量がたっぷり24 GBもあり、LoRAの素早い学習やフルHD以上の高解像度イラストの生成も対応できます。

神里綾華(LoRA + ControlNet)ベンチの生成時間は、RTX 4090が21.2秒、RTX 3090が39.6秒でした。ハローアスカと同じくほぼ2倍の生成スピードです。

神里綾華(LoRA + Latent x2.0)ベンチも約102%の性能差があり、RTX 4090のAIイラスト性能は現行最高峰です。

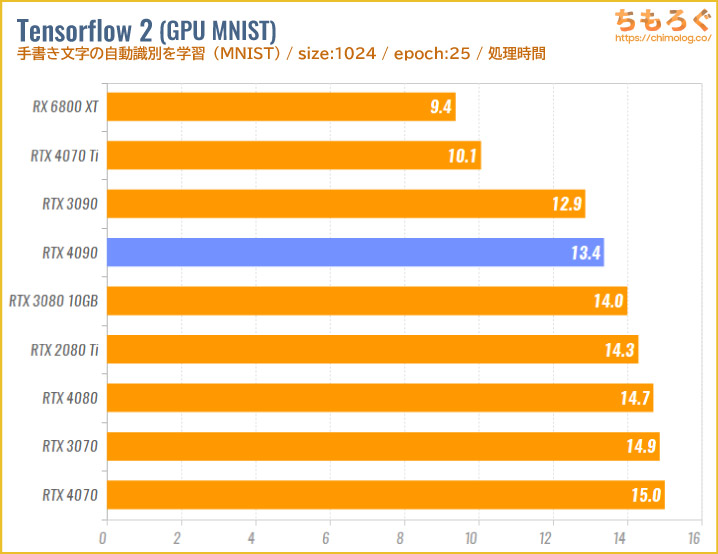

機械学習(Tensor Flow 2)

AnacondaプロンプトでTensor Flow 2をロードして、kerasパッケージの「手書き文字の識別トレーニング(MNIST)」を実行します。25 epochの学習にかかった時間が速いほど高性能です。

RTX 4090は13.4秒で学習を終え、RTX 3090は12.9秒でした。何がボトルネックになっているか原因が分からないですが、期待される性能と実際の学習時間が相関しません。

なお、RX 6800 XTはAnacondaで動かせなかったので、python 3.10.6にDirectML版のTensor Flow 2をロードして同じ内容のテストを行っています。

なぜかトップクラスに速いです。

動画編集(PremiereとDavinci)

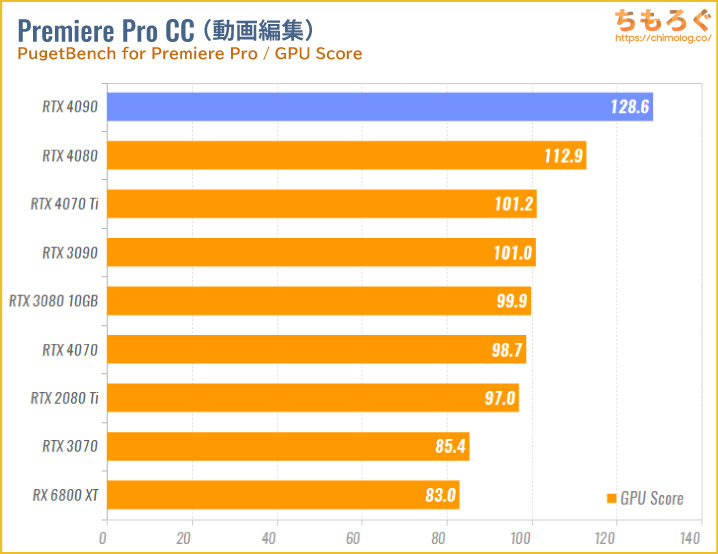

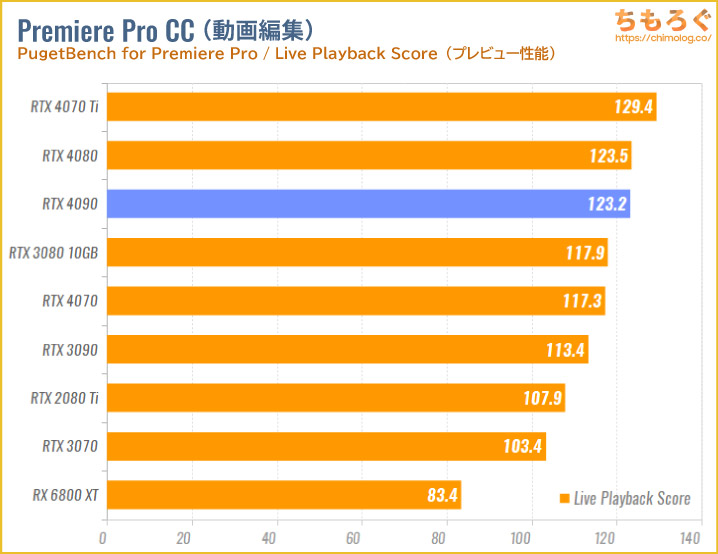

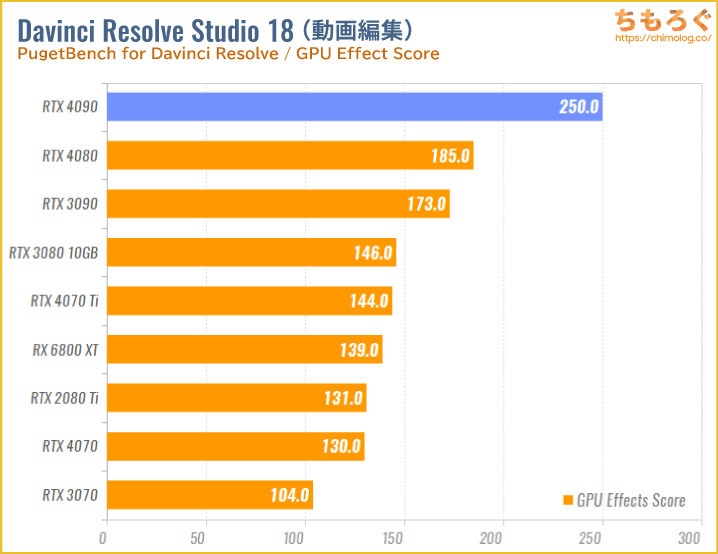

Puget Systemsのベンチマークプリセットを使って、動画編集の定番ソフト「Adobe Premiere Pro」と「Davinci Resolve Studio」のGPU性能をテストします。

テストに使用される動画素材は基本的に4K解像度以上で、割りと負荷の重たいワークロードです。

Premiere ProのGPUスコアは「128.6」で、RTX 4090から3割も伸びます。価格に見合う性能差か問われると、ちょっと微妙かもしれません。

素材のプレビュー性能(Live Playback)でも、目立った性能差が見られません。

Premiere Proの場合、グラフィックボードへの投資をほどほどにして、メインメモリ容量にお金を掛けた方が良さそうです。

Davinci Resolve StudioのGPUエフェクト性能は、RTX 4090が頂点です。RTX 3090より約45%も高性能です。

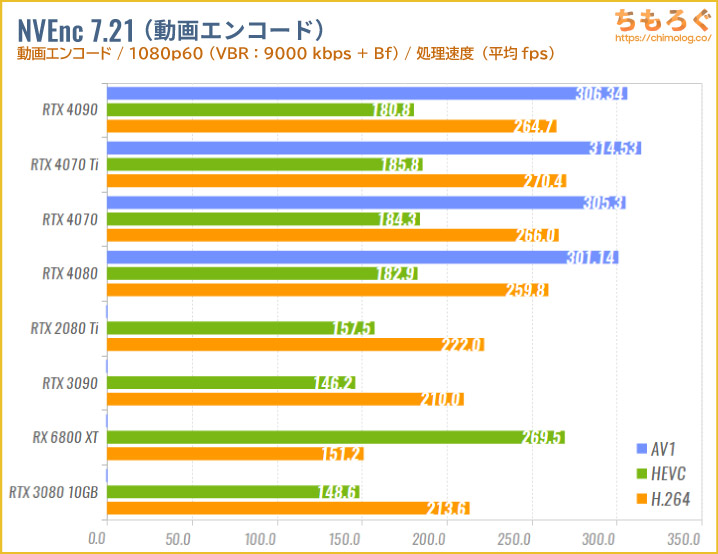

動画エンコード(NVEncなど)

| 世代 | RTX 4090 (Ada Lovelace世代) | RTX 3090 (Ampere世代) |

|---|---|---|

| エンコーダー | 第8世代NVEnc(2基) | 第7世代NVEnc(1基) |

| エンコード動画を「変換」する |

|

|

| デコーダー | 第5世代NVEnc | 第5世代NVEnc |

| デコード動画を「再生」する |

|

|

RTX 4000シリーズ(Ada Lovelace世代)は、第8世代NVEncエンコーダーを2基搭載します(※RTX 4070 Ti未満は1基のみ)。

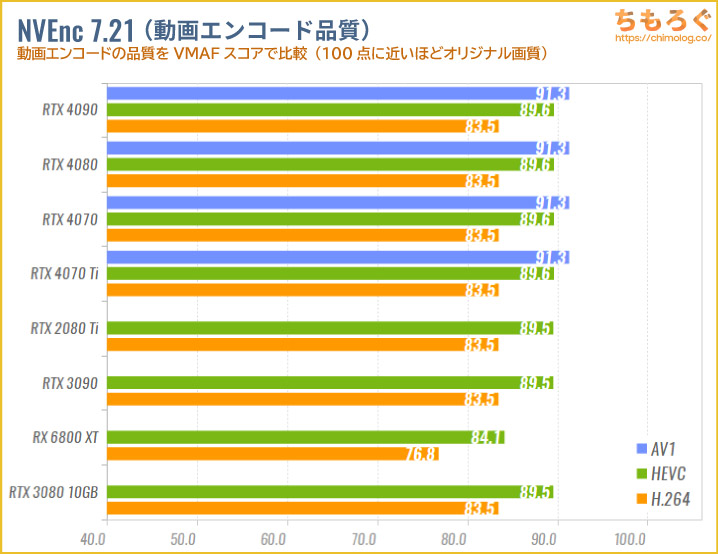

まずはrigayaさん作のAviutl拡張プラグイン「NVEnc 7.21」を使って、RTX 4080の動画エンコード性能を検証しましょう。

テスト内容は1分30秒ほどのフルHD動画(原神のプレイ動画)を、VBR形式(ビットレート9000 kbpsでBフレーム挿入あり)でエンコードするのみ。ログに記録される処理速度(fps)で性能を比較します。

RadeonはNVEncを使えないので、AMD VCE(VCEEnc)を使います。VBR形式(ビットレート9000 kbps)で、プリセット:Qualityです。

VCEEncではBフレーム挿入を使っても画質がまったく改善せず、いたずらにエンコード速度を半減させるだけなので、Bフレーム挿入をあえて使いません。

遅い割に画質が変わらない「罠」です。

RTX 4090の動画エンコード性能はかなり速いです。RTX 3090と比較して、H264エンコードで約1.2倍、HEVCエンコードで約1.26倍も高速です。

肝心のAV1エンコードで平均300 fps台に達し、H264やHEVCエンコードよりも速いです。

もちろん、エンコード品質(VMAFスコア)も優秀です。

HEVCとH264エンコードは従来世代とほぼ同じ画質ですが、AV1エンコードではHEVCを上回る画質です。HEVCとの差が小さいものの、エンコード性能が約1.7倍も違います。

見ての通り、VMAFスコアが高いほど高画質です。動きの多いゲームプレイかつ60 fps映像であれば、VMAFスコアによる画質差を体感しやすい傾向が強いです。

エフェクトのくっきり感、UIに表示されるテキストの輪郭線、圧縮しすぎによるブロックノイズの量など。VMAFスコアと映像の鮮明さにハッキリと関係性が見て取れます。

ゲーム開発(Unreal Engine 5)

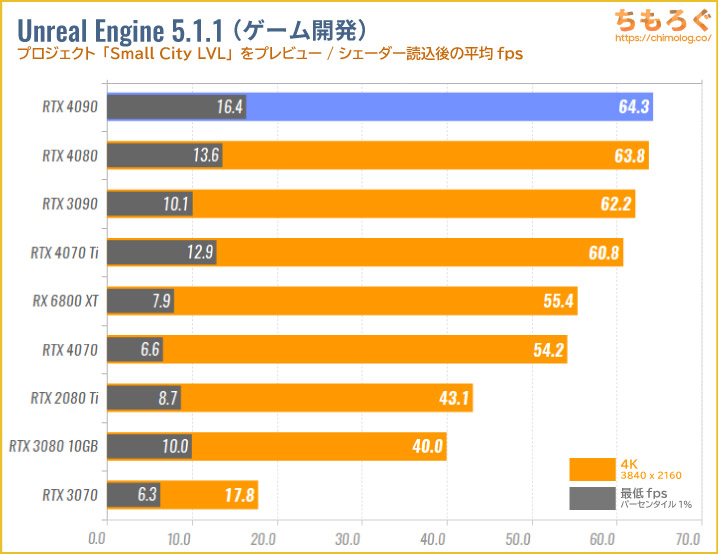

無料で使えるゲーム開発ソフト「Unreal Engine 5.1.1」のプレビュー性能をテストします。

無料で配布されている「City Sample(The Matrix Awakens)」から「Small_City_LVL」を読み込み、既定のルートを1周してフレームレートを測定します。

「Big_City_LVL」だとメインメモリ容量が不足して動作が不安定だったため、メモリ容量32 GBでもなんとか動作するSmall版をテストしました。

RTX 4090は平均64 fpsでした。テスト実行中に約10.2 GB前後のVRAMが確保される※ため、12 GB以上のVRAMと一定の演算性能があればフレームレートの伸びが飽和します。

開発中のプレビュー性能がどれほど重要かどうかは筆者には分からないですが、スムーズに動いた方が動作検証をしやすいと思われます。

なお、上記のテストではDXR(リアルタイムレイトレーシング)を有効化せずにテストしています。DXRを有効化すると、パフォーマンスの差がさらに開く可能性が高いです(特にRadeonに対して)。

※実際にVRAMを使っているかどうか判別が難しいので「確保」と表記しました。世の中にはVRAMがあればあるだけ確保してしまう(= 実際には使っていない)ゲームが存在し、勘違いの原因になっています。

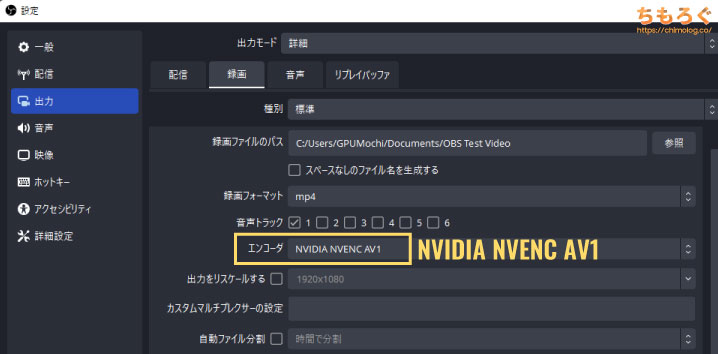

ゲーム実況配信(OBS Studio)

ゲーム配信で定番のソフト「OBS Studio」を使って、RTX 4090のゲーム配信性能を比較します。

フォートナイトのベンチマークモードを録画配信して、平均フレームレートやコマ落ち(ドロップフレーム率)を比較した結果がこちら↓

| RTX 4090で動画配信 | |||

|---|---|---|---|

| 設定 | 平均fps | 性能低下 | コマ落ち |

| フルHD(H264) | 253.2 fps | -7.8% | 0.7% |

| フルHD(AV1) | 248.7 fps | -9.5% | 0.9% |

| 4K(H264) | 169.6 fps | -9.2% | 0.2% |

| 4K(AV1) | 161.0 fps | -13.8% | 0.2% |

※フルHDはP4:Medium / VBR:9000 kbpsで、4KはP4:Medium / VBR:16000 kbpsでテスト

フルHDの場合、H264とAV1エンコードどちらも約8~9%の性能低下で、コマ落ちは1%前後で非常に安定しています。

4K解像度だとH264で約9%の性能低下、AV1では約14%の性能低下ですが、どちらもほとんどコマ落ちせず安定した配信と録画が可能です。

| RTX 3090で動画配信 | |||

|---|---|---|---|

| 設定 | 平均fps | 性能低下 | コマ落ち |

| フルHD(H264) | 217.4 fps | -9.7% | 0.3% |

| フルHD(AV1) | |||

| 4K(H264) | 92.0 fps | -11.4% | 95.5% |

| 4K(AV1) | |||

同じ設定のままRTX 3090で録画と配信をすると、フルHDは安定するものの4K解像度でまったく安定しません。約96%のコマ落ち、つまりほとんど何も映っていない状況です。

オーバーウォッチ2を4K解像度でリプレイモード中に録画して、AV1とH264で画質を比較しました。

画質の差が分かりやすいように、ビットレートを9000 kbps(フルHD換算で2250 kbps)まで下げている影響はありますが、AV1の方がはるかに高画質だと分かるはずです。

RTX 4090の消費電力を比較

電力ロガー機能のついた電源ユニットを2台使って、CPUとマザーボードに電力供給を分割します。

| テスト環境 | ||

|---|---|---|

| 850 W(80+ Platnium)使用モデル「Corsair HX850i」 | ||

| 850 W(80+ Gold)使用モデル「Toughpower iRGB PLUS」 | ||

システム全体を担当する電源ユニットから、+12Vレールの消費電力を見るとグラフィックボード単体の消費電力とほぼ一致します。

上記の接続方法だと、+12Vレールは基本的にグラフィックボード(6+2 pinとPCIeスロット)で使用されるため、CPUを取り除いておけば自ずとグラフィックボード単品の消費電力を抽出可能です。

ただし、電源ユニットの電力ロガーセンサーは刻み値が粗いです。変動幅が小さくなりがちな、低負荷時(低設定のフルHDなど)の精度はやや悪いです。

GPU単体の測定値を見るのではなく、他と比較して相対的に見るべきです。

誤:Aは平均200 Wらしい- 正:AはBと比較して50 W少ないらしい

これくらいのニュアンスでデータを見てくれると助かります。

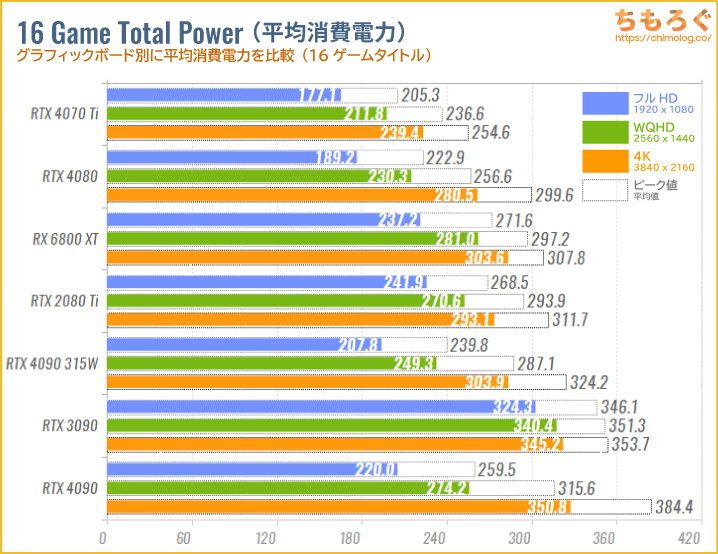

特定のゲームをプレイ中の消費電力ではなく、テストした16個のゲームタイトルから平均消費電力を求めます。

タルコフやMSFSに加え、RTX 4090自体が高性能過ぎてCPUボトルネックの影響が非常に大きいです。グラフィックボードがフル性能を出せているシーンが少なく、実際の消費電力は低めに出ます。

今回のテスト内容ではRTX 4090の消費電力はフルHDで平均220 W、WQHDで平均274 W、4Kですら平均350 Wです。出荷設定の最大値(450 W)に達するシーンはほぼ見られません。

参考までに、平均値で400 Wを超えたゲームはフォートナイト(4Kで平均420 W)、オーバーウォッチ2(4Kで平均430 W)だけでした。

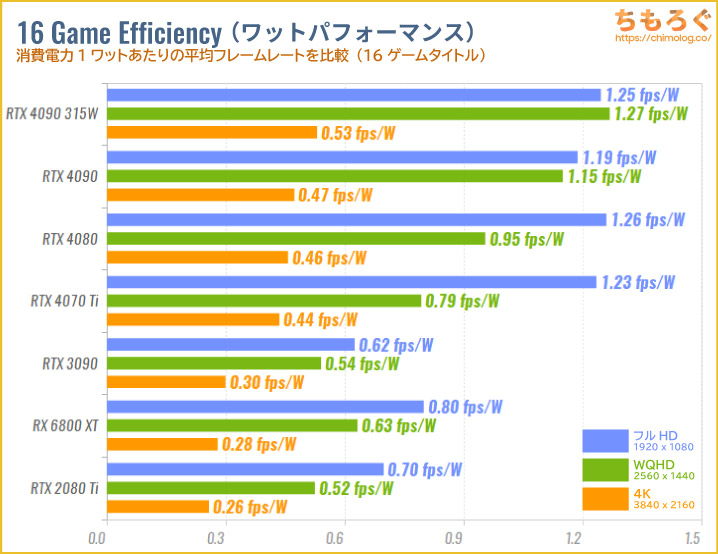

消費電力1ワットあたりの平均フレームレートを計算したグラフです。

言うまでもなくRTX 4090の電力効率は前世代(RTX 3090)と比較して劇的な進化です。フルHDで約1.56倍、WQHDで約2.13倍、4Kで約1.92倍もワットパフォーマンスが改善します。

電力制限70%(315 W制限)の場合だとフルHDで約1.77倍、WQHDで約2.35倍、4Kで約2.02倍と圧倒的なワットパフォーマンスを示します。

さすがTSMC 4N(TSMC 5 nm)プロセスです。

基本的にワットパフォーマンスはよほど下手な設計や、最適化不足のドライバでもない限り、製造技術である程度決まります。従来のSamsung 8 nm(改良版10 nm)がいかに不利だったかを物語っています。

高負荷時のGPU温度は?

GPU使用率が100%に達する「3DMark Speed Way」を10分連続で動かして、RTX 4090(GIGABYTE GAMING OC 24G)のGPUコア温度を測定したグラフです(※テスト時の気温は26℃前後)。

RTX 4090は10分を通して平均64.6℃(ピーク67℃)でした。RTX 3090よりテスト時の消費電力が100 W近く増えていますが、とてつもなく巨大化したボード設計で400 W超えの熱をうまく処理します。

315 W制限時なら平均58.7℃(ピーク67℃)に抑えられ、ファンの回転数も下げて運用できます。

グラフィックボードの温度比較は、テストに使用したボード設計に大きく左右されます。

とはいえRTX 4090の場合、各AIBが非常に巨大なボード設計を採用しているため、極端な性能差は出ないでしょう。内部設計の差で「動作音の割に冷えが悪い」モデルが存在するくらいで、全体的に冷却性能は優秀です。

許容温度に合わせてファンコントロールを制御して、好みにあった運用が可能です。

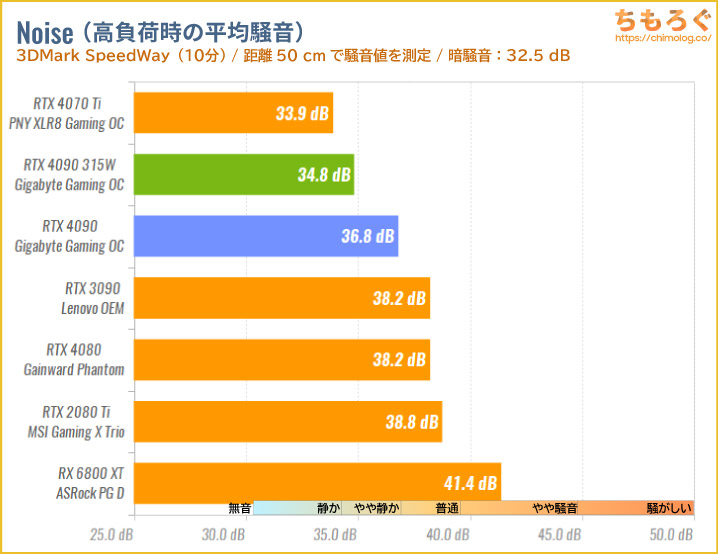

騒音を10分テスト(動作音はうるさい?)

デジタル騒音メーターを距離50 cmに置いて、騒音値を測定しました。

RTX 4090(GIGABYTE GAMING OC 24G)の動作音は「やや静か」を少し超える程度です。315 W制限時ならファンレス動作も加わって「静か」の領域に入ります。

全長340 mm、厚み75 mm(4スロット占有)、実測109 mm口径のトリプルファン。ボード内部に8本のヒートパイプ、銅製ベイパーチャンバー構造、VRMやVRAMにしっかり接着する大量のサーマルパッドなど。

豪華で巨大な設計を採用しているだけあって、さすがの冷却性能です。

許容温度を70℃まで引き上げると「静か(< 34.9 dB)」が容易になり、75℃まで許容すればほとんど無音に近い「極めて静か(< 32.5 dB)」も十分視野に入ります。

グラフィックボードの動作音(騒音)比較も、温度と同じくテストに使用したボード設計に大きく左右されます。

上記のグラフから確からしい情報は、特定のボード設計がどれくらい静かに動作できるかどうかに過ぎず、参考程度に見るべきです。

| 騒音値(dBA) | 評価 | 目安 |

|---|---|---|

| 30 ~ 32.49 | 極めて静か | 耳を近づければ聞こえるレベル |

| 32.5 ~ 34.9 | 静か | ファンが回っているのが分かる |

| 35 ~ 39.9 | やや静か | 扇風機を「小」で回したくらい |

| 40 ~ 42.49 | 普通 | エアコンよりは静かな音 |

| 42.5 ~ 44.99 | やや騒音 | エアコンの動作音に近い |

| 45 ~ 50 | 騒がしい | 扇風機を「中~大」で回した音 |

| 50 ~ | うるさい・・・ | 換気扇を全力で回した音 |

まとめ:RTX 4000シリーズで「最高の価値」

「RTX 4090」のデメリットと弱点

- CPUボトルネックの影響が大きい

※RTX 4090自体の弱点ではない - DLSS 3.0対応ゲームがまだ少ない

- 国内の販売価格が高い(26万円~)

- ボード設計が巨大でPCケースを選ぶ

「RTX 4090」のメリットと強み

- フルHDで360 fps↑が可能

- WQHDで300 fps↑も可能

- 手に届く4Kで144 fps↑

- fpsをドカッと増やす「DLSS 3.0」

- 改善されたワットパフォーマンス

- トップクラスのAIイラスト性能

- RTX 3090を凌駕するクリエイティブ性能

- 高画質で超高速な「AV1エンコード」

- 安定した配信性能(コマ落ちが少ない)

- 静かでよく冷えるボード設計が多い

- コストパフォーマンスが高い

RTX 4000で珍しく値上げ以上の性能上昇 - 配線がスッキリする「16 pin」

※非対応の電源では12VHPWRアダプタが必要

「RTX 4090」は決して安いとは言えないグラフィックボードですが、筆者が触ってきたRTX 4000シリーズでもっともコストパフォーマンスに優れています。

RTX 3090より100ドル(+7%)高いだけで、4Kゲーミング性能で約1.6倍(DLSS 3を含めて5倍に達する例も)、クリエイティブ性能やAIイラスト生成速度で約2倍の性能です。

消費電力の定格値が3割近く増えて450 Wとはいえ、実際に400 W以上を使うシーンは少ないです。特にゲーミング用途においてはCPUボトルネックの影響があり、思ったほど消費電力が増えていません。

それほど増えない消費電力の割に実効性能が大幅に改善され、RTX 3090を凌駕するワットパフォーマンスを実現します。

RTX 4000シリーズ最上位モデルだけに、なんとなく運用の敷居が高いと思われがちですが、実際は従来型の電源ユニットで何不自由なく適切に運用可能です。

「初めての自作だけどRTX 4090を使いたい」と考えている新規PCユーザーもまったく問題なし。しいて弱点を挙げるなら、以下の2点に要注意です。

- フルHD~WQHDでCPUボトルネックが非常に出やすい

- ボード設計が巨大で搭載できるPCケースを選びます

今回のベンチマークを見ての通り、RTX 4090はあまりにも高性能過ぎて、Core i9 13900Kを持ってしてもフルHD~WQHDで深刻なCPUボトルネックが発生します。

現時点のCPU性能ではRTX 4090の性能を100%引き出すのは困難で、実質的に4K~8Kゲーミングに特化したGPUです。

次に巨大なボード設計。3~4スロット占有かつ、全長30 cmを超える巨大なボード設計が当たり前で、干渉なくすっぽり収まるPCケースを選びます。

事前にPCケースの対応グラフィックボードサイズを確認しましょう。

RTX 4090は性能面でこれと言った欠点が見当たらない、本当に出来の良いグラフィックボードです。

自社と競合含めRTX 4090に取って代わるGPUが存在せず、おまけにコストパフォーマンスも良好。対応できない用途もほとんどなく、満足度の高い買い物になりました。

以上「RTX 4090を自腹レビュー & 比較ベンチマーク:2023年もぶっちぎりの最強グラボ」でした。

RTX 4090を単品で買う

今回のレビューで使用した「GIGABYTE GAMING OC 24G」がおすすめです。巨大設計 + ベイパーチャンバー + 8本ヒートパイプ + 109 mm径トリプルファンで静かによく冷えます。

実際に試してはいませんが、Founder’s EditionやASUS ROG STRIX OCと同じく最大600 W対応のvBIOSを搭載します。

豪華なハードスペックの割に、楽天やYahooショッピングのJoshin Webで実質24~25万円台から買える場合が多く、ショップ通販によってはまれに24万円台に値下げして売っているときもあります。

約24~25万円なら個人輸入と比較して値段に大差なく、標準2年保証 + 延長2年保証(製品登録が必要)が付いてくるので、RTX 4090搭載モデルの中で特にコスパが高い一品です。

もう一つの無難なおすすめは標準3年保証つきの玄人志向「GALAKURO」です。奥行き336 mm、厚み74 mmで4スロットを専有する分厚い設計で冷却性を高めます。

「1-Clip Booster 2.0(102 mmファン)」をバックプレートに取り付けて、冷却性能をさらに稼ぐギミックも付属します。

RTX 4090搭載ゲーミングPCを買う

手っ取り早く「完成品」が必要な方は、BTOメーカーのゲーミングPCを推奨します。

| ゲーミングPC | 主なスペックと価格 2023年4月時点のスペック |

|---|---|

パソコン工房 パソコン工房「LEVEL R779」 |

|

ストーム ストーム「PG-PXT13」 |

|

ツクモ ツクモ「G-GEAR GX9J」 |

|

現時点(2023/05)では、パソコン工房「LEVEL R779」がコスパの良いスペックです。

Core i9 13900KF(24コア32スレッド)に、360 mmラジエーター搭載の水冷式クーラーを使っています。最初から容量32 GBのDDR5メモリ、容量2 TBものNVMe SSDを搭載していて良心的です。

電源ユニットも容量1000 WでCore i9 + RTX 4090に十分ですし、カスタマイズ画面から約5000円の追加で容量1200(80+ Platinum)に変更もできます。

パーツの品質や拡張性を重視する方はストーム「PG-PXT13」や、ツクモ「G-GEAR GX9J」がやはり適任でしょう。特にストームは扱いやすい市販パーツを多用する割に価格が安く、自作PCユーザーからも評価が高いです。

RTX 4090を運用できる電源ユニット

容量850 Wの電源ユニットで十分で、予算に余裕あれば容量1000~1200 Wも候補です。

RTX 4090(vBIOS:450 W)に最大負荷を掛けても、平均420~430 W(ピーク460 W)程度です。グラフィックボード以外の消費電力を含めても、ゲーム中は600 W以内に収まる傾向が強く容量850 Wで事足ります。

過度に大容量な電源を買っても予算の無駄使いになりやすく、容量よりも質にコストを掛けたほうがいいでしょう。

コストパフォーマンス重視であれば「XPG Core Reactor 850W」や「Corsair RM850x」に、Corsair製12VHPWRアダプターの組み合わせがおすすめです。

ちなみに筆者がRM850xではなくHX850x 2021を使っているのは単に+12Vモニター機能(ロガー機能)が欲しいだけで、一般人にとって必要性の薄い機能です。

Corsair RM / RMxシリーズなど、Corsair電源ユニットでは別売りの「Corsair 12VHPWRフラットケーブル」を取り付けて、配線がスッキリする16 pinに対応できます。

ピンアサインが共通設計のXPG Core Reactorも同様です。

容量1000 Wでさらに余裕を持たせたい場合は「TOUGHPOWER GF3 PCI Gen5.0」や「CYBERCORE 1000 Platinum」がコスパ良し。

「ATX 3.0」「PCIe 5.0」対応などとアピールする電源ユニットは、全体的にコストパフォーマンスが悪いので注意(※特定の規格に対応 ≠ 高信頼や高性能)。

グラフィックボードのレビュー記事

おすすめゲーミングPC:7選

おすすめゲーミングPC:7選 ゲーミングモニターおすすめ:7選

ゲーミングモニターおすすめ:7選 【PS5】おすすめゲーミングモニター

【PS5】おすすめゲーミングモニター 初心者向け「ガレリア」の選び方

初心者向け「ガレリア」の選び方 NEXTGEAR 7800X3Dの実機レビュー

NEXTGEAR 7800X3Dの実機レビュー LEVEL∞の実機レビュー

LEVEL∞の実機レビュー GALLERIAの実機レビュー

GALLERIAの実機レビュー 【予算別】おすすめ自作PC:10選

【予算別】おすすめ自作PC:10選 おすすめグラボ:7選

おすすめグラボ:7選 おすすめのSSD:7選

おすすめのSSD:7選 CPUの性能比較表

CPUの性能比較表 おすすめの電源ユニット10選

おすすめの電源ユニット10選 おすすめなPCケース10選

おすすめなPCケース10選 地味に悩む、マザーボードの選び方

地味に悩む、マザーボードの選び方

やかもちのTwitterアカ

やかもちのTwitterアカ

アップお疲れ様です

性能が高いとはいえ、お値段もお高いですね。

ここまでのレベルとなると一般人には使いこなせないですわ

自腹の記述に引っかかって経費として落ちなくなるって聞いたけど

少し気になったのですが、s評価ではないのはどこが足を引っ張っているのでしょうか?

大きさはアレですが、唯一無二の最強性能でコスパもそ良くて、電力制限をすればワッパも優秀なら最上位評価でも問題無いような気がします。

国内実売価格だと価格差が7% → 30%前後に開くのが主な原因です。

RTX 4070に辛辣な理由も国内実売価格のせいです。

マイニングが流行っていた時のバグった値段と無意識に比べてましたけど、冷静に考えたら確かに高いですよね

4K144hzゲーミングとかAIクリエイター用途なら文句無しでSランクだよ。

ただ、そういった「極めた人」以外の一般ユーザーにとっては過剰スペックでしかないからSにはならない。

CPUの記事でi7・i9は「A+」止まりの一方、i5 12400が「S」評価なように、

ちもろぐさんの評価は一番人数が多いボリュームゾーンの一般ユーザー目線だから

この評価もまぁ妥当だよ。

(もしもこの評価が「ヘビーユーザー向け」「ノーマルユーザー向け」「ライトユーザー向け」の

3段階に分かれていたら、それぞれ「S」「B」「選ぶな」って感じになってるはず)

最近はあまりコスパってかライトユーザー目線ではない気がしますけどね…

4070がA評価だし

久しぶりに1050ti vs RX570の動画見たけどこのころは良かった、とか思ってしまう

やかもちさんも3060tiとかコスパお化けでめっちゃテンション上がってたよね

やっぱちもろぐはライトユーザーよりヘビーユーザーの閲覧が多くて高価なグラボのレビューが需要あるんだろうか

> やっぱちもろぐはライトユーザーよりヘビーユーザーの閲覧が多くて高価なグラボのレビューが需要あるんだろうか

一応、RX 6400、RX 6500 XT、RTX 3050などエントリーモデルのレビュー記事もアップしているので、その指摘はちょっと違うかも?

最近ハイエンドGPUの記事が多いのは、単にここ最近RTX 4070やRTX 4070 Tiが発売されたからで、これといった意図は無いです。

ただ・・・、RTX 3060 Tiのころと比較して、あまりワクワクできないのは確かにあります。

5月発売予定のRTX 4060 Tiはバス幅が128-bitのケチケチ仕様で嫌な予感しかしないし、同じく5月発売予定のRX 7600(無印)は5 nmではなくTSMC 6 nm製らしく・・・あまり興奮できないです。

マイニング特需が消滅して価格の上昇圧力が無くなったかと思えば、今度は米国のインフレ退治政策に影響されて円レートがずっと130円台に落ち着き、国内売価が悲惨な状況ですし・・・。最近のエントリ~ミドルにつらい気持ちがあるのは確かです。

そうですよね、最近2,3万のラインナップが薄いってのが大きいですよね…

このぐらいからミドル帯はやりたいゲームで目標とするfpsで選んだり、ディスプレイとの兼ね合いだったり、平均fpsで選んだりでいろいろと吟味する意味もありました

ただ残念ながらAIに基準を置くと身もふたもない言い方だけど最新世代でお金出せる範囲で上から、で終わっちゃう話(お金が出せないなら3060)で極端な話ベンチマークを見る意味すらないんですよね

しいて言えばstable diffusionならアスカベンチとりあえず見て大体の速度を確認するぐらいで十分

アプデや学習方法、使い方ですぐに変わってしまうので、「このぐらいが適当」って基準がなくハイエンドでVRAMを多く積んだ方が早いぐらいしか言えないというね

正直ベンチマークを眺める楽しみもなくなってしまったなあって感じます

価格の高さは総合力を考えると妥当、内容は申し分なくこれ以上ないほどのS評価だと思います。

しかしサイズが環境を選ぶほどまでの大きさになっているのはマイナスかなと。

モデルにもよるとは思いますが、総じてデカイ重いですね。

UWQHD以下だと4080との差が大きく縮む傾向なので、4090は4K~8Kで使ってこそ。

逆に4080は256bitのせいで4Kで性能が鈍り始めている。4Kでも3090Tiより1.2倍あるが。

PS5がアップスケール込みで4K60fpsを6万円で出せてしまう現状でわざわざゲーム目的で26万円のグラボを買う価値は正直見出せませんね…

どの程度の「画質」を追求するのか?・・・で評価が変わってしまいますね。

PS5の4K@60 Hzと、RTX 4090で出力する4K@60 Hzでは、画質がだいぶ違います。負荷が重たいシーンで出力解像度を下げる挙動もPS5だけで、RTX 4090はきちんとネイティブ3840×2160を維持しますし、DLSS 2.xやDLSS 3を使う手もあります。

詳しくないですが、機械学習ベンチにサイズ固定のMNISTって適当なんですか?

タスクが柔らかすぎてGPU以外の要素に引きずられやすい気もしますし、GPUのVRAMサイズを問わずにバッチサイズ固定してしまうと実際の利用状況とはかけ離れてしまう気もします

公式サイトのハードウェア性能を評価するチュートリアルコードを使っているので、性能の評価ができるのかな~と最初は思っていたのですが、いざこうして比較データが集まってくると「理論性能と相関しない・・・なんでだろう」と困惑してます。

学習時間ではなく、Blender Benchmark 3.5のように理論上の最大スループットを評価する方向性に切り替えようかなと考え中です。

ここまでCPUボトルネックがきついと、実質的にVR・AI用と言っても過言はなさそう

ハイエンドグラボはもはやゲーマーのためのものではないのですね

TSMCの最先端プロセスの製造原価が高すぎるせいで、NV / AMDともに値段設定のインフレがすごいですよね。

高い原価に見合う「値付け」ができるように、ゲーム以外の用途も推進する傾向が強まっています。製造プロセスが進んで製造原価が高騰するほど「ゲーマー以外もお客さん」という方向性は止まらないかと。

ウルトラハイエンドしかまともなグラボがないって革ジャンさぁ…

ライバルのせいでしょう。

そしてそれはTSMCのライバルにもいえる。

しかしRTX 4080は11月発売時、為替1ドル148円レートだったこともあって4090よりの価格で販売されたが、今は特に代理店直のモデル中心に下がっていて特にその一部のモデルは4090よりも狙い目になっている。

FPSゲームを4Kでやる馬鹿がどれだけ居るんだ

まあ好きにしたらいいけど

ここの管理人も「自腹で購入」と言いながら金銭感覚やら何やらぶっ壊れてきたな

もう一般人の参考にはならない

いるさ!ここに一人な!

小さい4Kモニターのほうが多少なりとも視認性上がってリフレッシュレートが同等ならば少し有利なんよ

もともとRTX 4090を買う予定は無かったですが、AIイラストベンチマークに便利過ぎて結局買うことに。他にもRVC Web UIやAuto GPTなど、ハイエンドGPUを使いこなしてくれるソフトが次々とリリースされているので、とにかく速いGPUが25万円くらいなら、まぁいいかなと思って買っただけです。

そもそも実用上のメリットが乏しい「Intel Optane SSD P5810X」を買うような筆者に、平均的な金銭感覚なんて無いです・・・。

だから「金銭感覚も人それぞれ」で終わる話だと思います。

狭くて速度制限も厳しい日本の公道で300 km/h出すわけでもないのに、数秒で100 km/hオーバーできる数千万する車を買う人もいるし、心拍数や血中酸素濃度すら測定できない機械仕掛けの時計に数百~数千万を払う人もいるし、一般人からはまったく用途が予想つかない100 TB超えのオールフラッシュNASを自作する人もいますね。

比較するとAD103以下のチップを使ってるGPUの残念さが際立つ

安ければいいんだけどそうじゃないからね…

いや今はRTX 4090 最安26万円で4080が17.5万円

性能差4K であっても1.35~1.4倍、それ以下だと1.2倍前後と考えると今は逆転している。

現状況下ではハイエンドはもう10数万で買える時代でもない。ましてや4080発売時の為替よりはマシだがまだかなりの円安でもあり。

次辺りはスターレイルも入るかなテストに

4kでレンダリング2.0の実質8kモードだと4080ですらアップアップになるとの噂

(記事と全く関係なくて恐縮ですがMOBIUZ EX240Nのレビュー待ってます・・・)

さすがTITAN枠の90さんやね

80と性能差ありすぎて笑える

現状 4090と4080で、1.2~1.35倍の性能差ある。

旧3080と3090では1.1~1.2倍差だったことを考えると大きいね。

ただし3080は10GBだったが4080は16GBで、1.6倍化したことで4080は性能差に見合ったバランスが備わり、4Kも十分こなせるパワーもあるので丁度良いともいえる。

来年にはAD103のフルスペックで5~10%アップした4080Tiが出てきそう。

その時に4080が14万円台まで下がっていれば非常に美味しそう。

しかし円安が収まらないと・・・

従来のTITANはこんなに性能差無かったから4090が異常

パフォーマンスゲインの幅を考えると他がしょっぱすぎるとも言う

26万のグラボ買ってゲームやっても結局チーターに蹂躙されるだけだからなぁ…それならゲームは治安もコスパもいいCSを選びますってなっちゃう

AIでもgeforceも企業やクリエイターを意識していて個人はあまり考慮してないですよ

イラストで言えば、そもそもstable diffusionはaom3やchilloutmixといった人気モデルが商業利用不可だし、大本のNAIモデルもdanbooruからの学習で感情的に受け入れられない人は多い

ならその辺がクリアですでにクオリティがめちゃくちゃ高いmidjourneyやnijijyourney、fireflyを利用する方がはるかに安全だしね

ChatGPTや合成音声も自分たちで作るより企業がいいものを近いうちに提供してくれるだろうし、個人での利用の大半はアングラな目的に収斂していくんじゃないかな

同意です。

アメリカでも訴訟が始まっていますからね。

4090の価格も、24万円台が毎週出てきていますから、皆殺しの3090tiに準じて動いているように感じます。

(新品の昨年来の値動きもさることながら、旧ハイエンドの実勢価格は中古価格ですしね、1年で半額以下とは…)

歩留まりは改善するし、この値段で買う人はそうそう湧いて出てきません。

原神って設定で強制的に60fpsに制限されるはずなんですけどリミッター外す方法あるのか

グラフでは下位に沈んでいる2080Tiですが、比較相手の数値が無駄に高いだけで、

実用性能では約5年経っても最上位クラスなんですね。

ここ数年で性能・価格ともにインフレが凄いことになっていますが、

寿命が近いであろう1080/2080系ユーザーの乗換先ってどこなんでしょうか。

煽り抜きで2080tiくらいしか存在しないんじゃないか?

2080tiはかなり優秀で今の相場なら買いの逸品だと思う

同価格帯よりメモリが潤沢で色々できる

型番でなく発売当初の実質価格で比べていくと碌な置き換え先がない

1080の置き換えはケースバイケースでスコアが1080未満のゲームもあるがAI遊びができる3060

もしくはゲーム向け3060tiになる

アップグレードは感じられない

16xxが現役で低価格帯に居座ってるせいで同世代の2080も行き場がない

3080と4070がほぼ同性能で2080のいた価格帯に存在してるのでそこにいくのか

いやいや2080ti買ってお茶を濁すわって感じ

記憶が正しければタルコフはゲーム内設定で垂直同期をオンにすると144fpsの上限がなくなるのでfpsの頭打ちが無くなりますよ

毎週のように25万円以下が散見されるようになってきているので、3090tiの様な経過だなと思ってみています。

前述の3090tiの過去の価格推移、歩留まりも改善するでしょうし、この値段で買う人は限られているでしょうから、今は待ちだなと考えています

AI用は最近特に5月になって半年以上待ちとかかなりの供給不足になっている。

よって価格が大幅に上昇している。RTX用をそちらにまわす展開に。

RTXは市場在庫で当面は回るはずで影響はあまりなさそう。

お聞きしたいのですが、

CORSAIRの12VHPWRケーブル(8ピン×2…?)とNZXTのC850の組み合わせで、ASUS TUFのRTX4090使えますか?

12VHPWRの規格あんまり分からなくて…Corsairのケーブルは2本ですが、足りているのが判断できないです。

各電源メーカーがリリースしている純正12VHPWRケーブルを買ったほうがいいですよ

そもそも他社のものはコネクタが合わないのと、もしコネクタが挿さったとしても電源側のピン配列が違ったらショートして燃えます

良くわかっていないのであればなおさら、最初から12VHPWRコネクタのある電源を買ったほうが安全かと

レビューお疲れ様です。

12VHPWRコネクタについて

販売数に対して発生件数はかなり少ないと思われますが

Redditのほうで、半年経って突然焦げたという報告が上がったり

きっちり差し込んでいるにも関わらず焦げたという報告もあったりして

まだ信頼性に不安が残るのが残念なところです

https://twitter.com/Sebasti66855537/status/1660761896658644992

全体でいうと1%どころか0.1%にも満たない初期不良よりも少なさそうですが、あるにはあるという感じのようですね。

きっちり差し込んでいる状態であったかは怪しいですが、特に450W超級の4090は懸念される部分なのは間違いないですね。

日本では起きていないのもかなり不可解ですね。

日本人の几帳面さでケーブル管理がもともと丁寧でしっかりしていたからかもしれませんが、情報がまったくない初期でも起こっていないところからも、丁寧さよりガサツさのほうが問題のようでもあり、あるいは日本にはない別の要因があって焦げているのかなとも。

RTX 4080とはグラフィック性能では1.25~1.35倍でしたが、AI用途ではVRAM 16GBと24GBの差が大きくでるようで1.5倍程度以上(最大では倍)あり、同じ24GBの3090が4080と同等以下ということで存在感をより増したかなと。

4080が実質16万円台で普通に買えるようになり、12VHPWRの心配はまずなくワットパフォーマンスNo1で4080が一番お勧めと思っていましたが、AI用となると実質22万円台と4080の約1.4倍でもその価値ありですね。

数か月前から4090を狙っていたものだが(年末のセールで買うつもりだった)(年末をワクワクしながら待ってた)、

現在、アメリカが中国に対して行った輸出規制の影響とかで(なんでも4090は高性能すぎてAIを使った兵器なんかに利用できるから奴らに渡したらあかんとか)、

……10月くらいから価格が爆上がりしている。(涙)

ようわからんが、規制発動までまだ猶予があるから、

中国人が今のうちだー! と爆買いしたり、アメリカの企業が駆け込み需要を狙って、向こうに在庫持ってったらしい。

そのせいで一時期24万くらいだった4090は、素で30数万円以上に。発売当初より高いとか、えぐい(涙)。

なんだ、ホトトギスは鳴くまで待つより、即座に狩った方が後悔が少ないとか、PCは欲しいときが買い時。とか、そういう感じの話。